Mysql配置优化浅谈

安装MySQL后,配置文件my.cnf在MySQL安装目录/share/mysql目录中,该目录中还包含多个配置文件可供参考,有my-large.cnf ,my-huge.cnf, my-medium.cnf,my-small.cnf,分别对应大中小型数据库应用的配置。win环境下即存在于MySQL安装目录中的.ini文件。

下面列出了对性能优化影响较大的主要变量,主要分为连接请求的变量和缓冲区变量。

一、连接请求的变量

max_connections

MySQL的最大连接数,增加该值增加mysqld要求的文件描述符的数量。如果服务器的并发连接请求量比较大,建议调高此值,以增加并行连接数量,当然这建立在机器能支撑的情况下,因为如果连接数越多,介于MySQL会为每个连接提供连接缓冲区,就会开销越多的内存,所以要适当调整该值,不能盲目提高设值。如下:

数值过小会经常出现ERROR 1040: Too many connections错误,可以过‘conn%’通配符查看当前状态的连接数量,以定夺该值的大小。

show variables like ’max_connections‘ 查看最大连接数

show status like ‘max_used_connections’ 查看响应的连接数

mysql> show variables like ‘max_connections‘;

+———————–+——-+

| Variable_name | Value |

+———————–+——-+

| max_connections | 256 |

+———————–+——-+

mysql> show status like ‘max%connections‘;

+———————–+——-+

| Variable_name | Value |

+—————————-+——-+

| max_used_connections | 256|

+—————————-+——-+

max_used_connections / max_connections * 100% (理想值≈ 85%)

如果max_used_connections跟max_connections相同 那么就是max_connections设置过低或者超过服务器负载上限了,低于10%则设置过大。

back_log

MySQL能暂存的连接数量。当主要MySQL线程在一个很短时间内得到非常多的连接请求,这就起作用。如果MySQL的连接数据达到max_connections时,新来的请求将会被存在堆栈中,以等待某一连接释放资源,该堆栈的数量即back_log,如果等待连接的数量超过back_log,将不被授予连接资源。

back_log值指出在MySQL暂时停止回答新请求之前的短时间内有多少个请求可以被存在堆栈中。只有如果期望在一个短时间内有很多连接,你需要增加它,换句话说,这值对到来的TCP/IP连接的侦听队列的大小。

当观察你主机进程列表(mysql> show full processlist),发现大量264084 | unauthenticated user | xxx.xxx.xxx.xxx | NULL | Connect | NULL | login | NULL 的待连接进程时,就要加大back_log 的值了。

默认数值是50,可调优为128,对于Linux系统设置范围为小于512的整数。

interactive_timeout

一个交互连接在被服务器在关闭前等待行动的秒数。一个交互的客户被定义为对mysql_real_connect()使用CLIENT_INTERACTIVE 选项的客户。二、缓冲区变量

默认数值是28800,可调优为7200。

全局缓冲:

key_buffer_size

key_buffer_size指定索引缓冲区的大小,它决定索引处理的速度,尤其是索引读的速度。通过检查状态值Key_read_requests和Key_reads,可以知道key_buffer_size设置是否合理。比例key_reads / key_read_requests应该尽可能的低,至少是1:100,1:1000更好(上述状态值可以使用SHOW STATUS LIKE ‘key_read%’获得)。举例如下:

key_buffer_size只对MyISAM表起作用。即使你不使用MyISAM表,但是内部的临时磁盘表是MyISAM表,也要使用该值。可以使用检查状态值created_tmp_disk_tables得知详情。

mysql> show variables like ‘key_buffer_size‘;

+——————-+————+

| Variable_name | Value |

+———————+————+

| key_buffer_size | 536870912 |

+———— ———-+————+

key_buffer_size为512MB,我们再看一下key_buffer_size的使用情况:

mysql> show global status like ‘key_read%‘;

+————————+————-+

| Variable_name | Value |

+————————+————-+

| Key_read_requests| 27813678764 |

| Key_reads | 6798830 |

+————————+————-+

一共有27813678764个索引读取请求,有6798830个请求在内存中没有找到直接从硬盘读取索引,计算索引未命中缓存的概率:

key_cache_miss_rate =Key_reads / Key_read_requests * 100%,设置在1/1000左右较好

默认配置数值是8388600(8M),主机有4GB内存,可以调优值为268435456(256MB)。

query_cache_size

使用查询缓冲,MySQL将查询结果存放在缓冲区中,今后对于同样的SELECT语句(区分大小写),将直接从缓冲区中读取结果。举例如下:

通过检查状态值Qcache_*,可以知道query_cache_size设置是否合理(上述状态值可以使用SHOW STATUS LIKE ‘Qcache%’获得)。如果Qcache_lowmem_prunes的值非常大,则表明经常出现缓冲不够的情况,如果Qcache_hits的值也非常大,则表明查询缓冲使用非常频繁,此时需要增加缓冲大小;如果Qcache_hits的值不大,则表明你的查询重复率很低,这种情况下使用查询缓冲反而会影响效率,那么可以考虑不用查询缓冲。此外,在SELECT语句中加入SQL_NO_CACHE可以明确表示不使用查询缓冲。

与查询缓冲有关的参数还有query_cache_type、query_cache_limit、query_cache_min_res_unit。

query_cache_type指定是否使用查询缓冲,可以设置为0、1、2,该变量是SESSION级的变量。

query_cache_limit指定单个查询能够使用的缓冲区大小,缺省为1M。

query_cache_min_res_unit是在4.1版本以后引入的,它指定分配缓冲区空间的最小单位,缺省为4K。检查状态值Qcache_free_blocks,如果该值非常大,则表明缓冲区中碎片很多,这就表明查询结果都比较小,此时需要减小query_cache_min_res_unit。

mysql> show global status like ‘qcache%‘;

+——————————-+—————–+

| Variable_name | Value |

+——————————-+—————–+

| Qcache_free_blocks | 22756 |

| Qcache_free_memory | 76764704 |

| Qcache_hits | 213028692 |

| Qcache_inserts | 208894227 |

| Qcache_lowmem_prunes | 4010916 |

| Qcache_not_cached | 13385031 |

| Qcache_queries_in_cache | 43560 |

| Qcache_total_blocks | 111212 |

+——————————-+—————–+

mysql> show variables like ‘query_cache%‘;

+————————————–+————–+

| Variable_name | Value |

+————————————–+———–+

| query_cache_limit | 2097152 |

| query_cache_min_res_unit | 4096 |

| query_cache_size | 203423744 |

| query_cache_type | ON |

| query_cache_wlock_invalidate | OFF |

+————————————–+—————+

查询缓存碎片率= Qcache_free_blocks / Qcache_total_blocks * 100%

如果查询缓存碎片率超过20%,可以用FLUSH QUERY CACHE整理缓存碎片,或者试试减小query_cache_min_res_unit,如果你的查询都是小数据量的话。

查询缓存利用率= (query_cache_size – Qcache_free_memory) / query_cache_size * 100%

查询缓存利用率在25%以下的话说明query_cache_size设置的过大,可适当减小;查询缓存利用率在80%以上而且Qcache_lowmem_prunes > 50的话说明query_cache_size可能有点小,要不就是碎片太多。

查询缓存命中率= (Qcache_hits – Qcache_inserts) / Qcache_hits * 100%

示例服务器查询缓存碎片率=20.46%,查询缓存利用率=62.26%,查询缓存命中率=1.94%,命中率很差,可能写操作比较频繁吧,而且可能有些碎片。

每个连接的缓冲:

record_buffer_size

每个进行一个顺序扫描的线程为其扫描的每张表分配这个大小的一个缓冲区。如果你做很多顺序扫描,你可能想要增加该值。

默认数值是131072(128K),可改为16773120 (16M)

read_rnd_buffer_size

随机读缓冲区大小。当按任意顺序读取行时(例如,按照排序顺序),将分配一个随机读缓存区。进行排序查询时,MySQL会首先扫描一遍该缓冲,以避免磁盘搜索,提高查询速度,如果需要排序大量数据,可适当调高该值。但MySQL会为每个客户连接发放该缓冲空间,所以应尽量适当设置该值,以避免内存开销过大。

一般可设置为16M

sort_buffer_size

每个需要进行排序的线程分配该大小的一个缓冲区。增加这值加速ORDER BY或GROUP BY操作。

默认数值是2097144(2M),可改为16777208 (16M)。

join_buffer_size

联合查询操作所能使用的缓冲区大小

record_buffer_size,read_rnd_buffer_size,sort_buffer_size,join_buffer_size为每个线程独占,也就是说,如果有100个线程连接,则占用为16M*100

table_cache

表高速缓存的大小。每当MySQL访问一个表时,如果在表缓冲区中还有空间,该表就被打开并放入其中,这样可以更快地访问表内容。通过检查峰值时间的状态值Open_tables和Opened_tables,可以决定是否需要增加table_cache的值。如果你发现open_tables等于table_cache,并且opened_tables在不断增长,那么你就需要增加table_cache的值了(上述状态值可以使用SHOW STATUS LIKE ‘Open%tables’获得)。注意,不能盲目地把table_cache设置成很大的值。如果设置得太高,可能会造成文件描述符不足,从而造成性能不稳定或者连接失败。

1G内存机器,推荐值是128-256。内存在4GB左右的服务器该参数可设置为256M或384M。

max_heap_table_size

用户可以创建的内存表(memory table)的大小。这个值用来计算内存表的最大行数值。这个变量支持动态改变,即set @max_heap_table_size=#

这个变量和tmp_table_size一起限制了内部内存表的大小。如果某个内部heap(堆积)表大小超过tmp_table_size,MySQL可以根据需要自动将内存中的heap表改为基于硬盘的MyISAM表。

tmp_table_size

通过设置tmp_table_size选项来增加一张临时表的大小,例如做高级GROUP BY操作生成的临时表。如果调高该值,MySQL同时将增加heap表的大小,可达到提高联接查询速度的效果,建议尽量优化查询,要确保查询过程中生成的临时表在内存中,避免临时表过大导致生成基于硬盘的MyISAM表。

mysql> show global status like ‘created_tmp%‘;

+——————————–+———+

| Variable_name | Value |

+———————————-+———+

| Created_tmp_disk_tables | 21197 |

| Created_tmp_files | 58 |

| Created_tmp_tables | 1771587 |

+——————————–+———–+

每次创建临时表,Created_tmp_tables增加,如果临时表大小超过tmp_table_size,则是在磁盘上创建临时表,Created_tmp_disk_tables也增加,Created_tmp_files表示MySQL服务创建的临时文件文件数,比较理想的配置是:

Created_tmp_disk_tables / Created_tmp_tables [i] 100% <= 25%比如上面的服务器Created_tmp_disk_tables / Created_tmp_tables [/i] 100% =1.20%,应该相当好了

默认为16M,可调到64-256最佳,线程独占,太大可能内存不够I/O堵塞

thread_cache_size

可以复用的保存在中的线程的数量。如果有,新的线程从缓存中取得,当断开连接的时候如果有空间,客户的线置在缓存中。如果有很多新的线程,为了提高性能可以这个变量值。

通过比较 Connections和Threads_created状态的变量,可以看到这个变量的作用。

默认值为110,可调优为80。

thread_concurrency

推荐设置为服务器 CPU核数的2倍,例如双核的CPU, 那么thread_concurrency的应该为4;2个双核的cpu, thread_concurrency的值应为8。默认为8

wait_timeout

指定一个请求的最大连接时间,对于4GB左右内存的服务器可以设置为5-10。三、配置InnoDB的几个变量

innodb_buffer_pool_size

对于InnoDB表来说,innodb_buffer_pool_size的作用就相当于key_buffer_size对于MyISAM表的作用一样。InnoDB使用该参数指定大小的内存来缓冲数据和索引。对于单独的MySQL数据库服务器,最大可以把该值设置成物理内存的80%。

根据MySQL手册,对于2G内存的机器,推荐值是1G(50%)。

innodb_flush_log_at_trx_commit

主要控制了innodb将log buffer中的数据写入日志文件并flush磁盘的时间点,取值分别为0、1、2三个。0,表示当事务提交时,不做日志写入操作,而是每秒钟将log buffer中的数据写入日志文件并flush磁盘一次;1,则在每秒钟或是每次事物的提交都会引起日志文件写入、flush磁盘的操作,确保了事务的ACID;设置为2,每次事务提交引起写入日志文件的动作,但每秒钟完成一次flush磁盘操作。

实际测试发现,该值对插入数据的速度影响非常大,设置为2时插入10000条记录只需要2秒,设置为0时只需要1秒,而设置为1时则需要229秒。因此,MySQL手册也建议尽量将插入操作合并成一个事务,这样可以大幅提高速度。

根据MySQL手册,在允许丢失最近部分事务的危险的前提下,可以把该值设为0或2。

innodb_log_buffer_size

log缓存大小,一般为1-8M,默认为1M,对于较大的事务,可以增大缓存大小。

可设置为4M或8M。

innodb_additional_mem_pool_size

该参数指定InnoDB用来存储数据字典和其他内部数据结构的内存池大小。缺省值是1M。通常不用太大,只要够用就行,应该与表结构的复杂度有关系。如果不够用,MySQL会在错误日志中写入一条警告信息。

根据MySQL手册,对于2G内存的机器,推荐值是20M,可适当增加。

innodb_thread_concurrency=8

推荐设置为 2*(NumCPUs+NumDisks),默认一般为8

原文作者:破修电脑的

分享原文地址:http://www.cnblogs.com/Bozh/archive/2013/01/22/2871545.html 收起阅读 »

Msyql备份之mysqldump介绍

把一个库导出到一个SQL文件

mysqldump -uroot -ppassword db_name > /data/rh/db_name.sql

备份多个库(使用-B参数)

-B, --databases Dump several databases. Note the difference in usage; in

this case no tables are given. All name arguments are

regarded as database names. 'USE db_name;' will be

included in the output.

如果需要指定字符集的话,可以使用--default-character-set参数。

备份全部库

mysqldump -uroot -ppassword --all-databases > /data/rh/db_all.sql

备份某个表

mysqldump -uroot -ppassword dbname table_name > /data/rh/table_name.sql

备份某库多个表

mysqldump -uroot -ppassword dbname tb1_name tb2_name > /data/rh/tb1_tab2.sql

备份数据库的表结构

mysqldump -uroot -ppassword -q -d dbname > /data/bakm3310/dbname.sql

-q 就是忽略缓存数据

-d 就是没有数据行信息

导出某库某表的结构

mysqldump -uroot -ppassword -d dbname tbname > /data/rh/tbname.sql

导出某库某表的内容

mysqldump -uroot -ppassword -t dbname tbname > /data/rh/tbname.sql二、恢复数据

-t 没有创建表的创建信息

有两种恢复方式如下:

第一种

mysql -uroot -ppassword db_name < /data/rh/db_name.sql

第二种

#mysql -u root -ppasword收起阅读 »

mysql> use db_name;

mysql> source /data/rh/db_name.sql;

mysql的ERROR 2006 (HY000): MySQL server has gone away错误分析

> ll *.sql上面可以看到,文件大小为27M导入的时候会报这个错误。

-rwxr-xr-x@ 1 bohan staff 27M Mar 26 18:08 91620_all.sql

[quote] mysql test < 91620_all.sql

ERROR 2006 (HY000) at line 17128: MySQL server has gone away

错误原因

If you are using the mysql client program, its default max_allowed_packet variable is 16MB. To set a larger value, start mysql like this:

shell> mysql --max_allowed_packet=32M

That sets the packet size to 32MB.

我们通过MySQL相关文档可以发现默认大小是16M。

解决方法

所有大于16M的SQL文件都会报这个错误,我们可以直接通过命令后增加--max_allowed_packet=32M解决或者登录MySQL客户端,修改系统变量:

> ssh mysql我们也可以通过修改MySQL配置my.cnf文件,在最后一行增加max_allowed_packet=32M就可以了

mysql> set GLOBAL max_allowed_packet=32[i]1024[/i]1024;

MySQL配置文件的位置:

Windows下 C:\ProgamData\MySQL\MySQL Server5.6原文地址:开源技术社区分享[/quote] 收起阅读 »

Linux下 /etc/mysql

Mac下通过brew安装 /usr/local/Cellar/mysql/5.6.23

Mysql主从复制

一. mysql的主从原理

mysql主从架构是当前比较成熟的高可用架构,配置也比较简单。

实现原理是:mysql主服务器将自己的操作记录例如增删改查等写入到binlog文件中去,而mysql从服务器,则开启两个线程

Slave_IO_Running和Slave_SQL_Running,IO线程是负责读取master的日志文件并写入到slave中的relay-log文件中,而sql线程则负责解析relay-log日志文件,将日志文件解析成

mysql从服务器可以执行的sql语句,写入到mysql从的库中,从而完成mysql的主从复制

二. mysql的基础知识

a. mysql中最常见的存储引擎为MyISAM和Innodb,其中innodb是支持事务,MyISAM不支持事务,支持事务是支持回归

b. myISAM中的每个库的每张表都会有3个文件.frm .myd .myi,其中frm文件为存放元数据信息,myd为存放数据,myi为存放索引的文件

c. innodb中如果是独享表空间的话,每个表一个ibd文件,而共享表空间的话,则所有表共同用ibdata文件

d. mysql主从复制中,在slave端存放的master.info文件是存放了该slave的master的相关信息,比如master机的IP,用户名,密码等信息而mysql-relay-bin文件是slave的IO线程从

master的binlog中读取到的信息,读取后在由slave的sql线程去解析此日志,并在slave端执行语句,完成主从复制,而relay-log.info文件和master.info文件的功能类似,此文件存放了

slave通过IO线程写入到slave的relay-log的相关信息

e. 在my.cnf配置文件中,有很多中括号,这里的每个中括号定义了针对每个组件使用的参数,例如mysqld组则是定义了mysql的启动参数,而mysqldump则是定义了在使用mysqldmp命令时要

用到的参数等等

f. mysql是一个模块化的组织结构,每个功能都是由相对应的功能模块来完成的,这里面有个query cache模块,就是完成了查询的缓存功能,当客户端提交了query请求后,如果服务器端在内

存中有此query的缓存结果则直接返回给客户端,如果没有缓存,则去执行此query 还有一个模块就是存储引擎模块,比如MyISAM和innodb在mysql中都是以模块的形式存在的,这个是mysql

独有的功能

三. mysql主从的实现

在主上的my.cnf文件中配置:

[mysqld]

log-bin=mysql-bin

server-id=1

在主上执行命令:

grant replication slave on [i].[/i] to 'sync'@'192.168.0.2' identified by '123456';

flush privileges;

show master status; 记录此命令打印出来的两个值

mysqldump -u root -p master> master.sql #备份master数据库,此命令在shell中执行

在从上的my.cnf文件中配置:

[mysqld]

server-id=2

在从上执行命令:

此处的master_log_file和master_log_pos两个值就是show master status中打印出来的两个值

stop slave;

change master to master_host='192.168.0.1',master_user='sync',master_password='123456',master_log_file='mysql-bin.000001' ,master_log_pos=23;

create database master;

mysql -u root -p master < master.sql #在从上导入master数据库,此命令在shell中执行

start slave;

四. mysql主从的验证

在从上执行命令:

show slave status; #如果显示 Slave_IO_Running和Slave_SQL_Running都是YES状态的话,则表明线程正常

五. MySQL主从同步实例 (这里的命令执行的位置不在标明)

背景: 两台MySQL配置了主从同步,由于MySQL从机的硬盘报警,现需要将MySQL从机迁移到一台新服务器上,两个MySQL都是5.1.37版本

迁移步骤:初始化:

[list=1]

[*]由于两台MySQL都是线上服务器,而且都已经在运行且实时同步,所以在迁移的过程中,既要不影响使用,又要保证数据的完整性[/*]

[*]在从机上操作(出故障的机器):[/*]

[/list] stop slave;

show slave status; #记录此处打印出的binlog的文件名和position两个值

scp -r /var/lib/mysql/db_monitor_service root@1.2.3.4:/usr/local/src

scp /etc/my.cnf root@1.2.3.4:/usr/local/src

[list=1]

[*]在需要重新部署从库的机器上操作:[/*]

[/list] 编译安装mysql5.1.37,且完成初始化和目录权限配置

在编译的时候,有一个地方需要注意,使用如下编译参数:

./configure --prefix=/usr/local/mysql5-3309 --enable-thread-safe-client --with-plugins=max-no-ndb --enable-assembler --with-tcp-port=3309 --

with-unix-socket-path=/usr/local/mysql5-3309/var/mysql.sock

在make的时候会有一个报错,解决这个错误需要修改Makefile文件,将文件的最后几行中的do_abi_check:后面的语句一直到done都全部删除,但do_abi_check:需要保留,保存后执行

make和make install安装

rm -f /etc/mysql/my.cnf #如果有就删掉,删之前确认此机器上没有别的mysql实例(unbutu)

rm -f /etc/my.cnf #如果有就删掉,删之前确认此机器上没有别的mysql实例(unbuntu)

/usr/local/mysql5-3309/bin/mysql_install_db --basedir=/usr/local/mysql5-3309 --datadir=/usr/local/mysql5-3309/var --user=mysql启动MySQL:

mkdir /data1/var_3309/

chown -R mysql:mysql /data1/var_3309/

/usr/local/mysql5-3309/bin/mysqld_safe --defaults-file=/usr/local/mysql5-3309/etc/my.cnf停止MySQL:

/usr/local/mysql5-3309/bin/mysqladmin -u root -p shutdown通过select语句查看最新数据是否和主库完成了同步 收起阅读 »

mv /usr/local/src/db_monitor_service /var/lib/mysql/

mv /usr/local/src/my.cnf /etc/my.cnf

change master to master_host='192.168.0.1',master_user='sync',master_password='123456',master_log_file='mysql-bin.000001' ,master_log_pos=23;

start slave;

show slave status; #验证可用性和数据的完整性

MySQL replicate-ignore-db详解

官方的解释是:在主从同步的环境中,replicate-ignore-db用来设置不需要同步的库。解释的太简单了,但是里面还有很多坑呢。

生产库上不建议设置过滤规则。如果非要设置,那就用Replicate_Wild_Ignore_Table: mysql.%这种方式。实验探坑如下:

第一种情况

从库:

replicate-ignore-db = mysql

主库:

use mysql

CREATE TABLE test.testrepl1(

id int(5))ENGINE=INNODB DEFAULT CHARSET=UTF8;

从库不会同步。坑!

第二种情况

从库:

replicate-ignore-db = mysql

主库:

use test

CREATE TABLE mysql.testrepl2(

id int(5))ENGINE=INNODB DEFAULT CHARSET=UTF8;

从库不会同步。坑!

第三种情况

use test

update mysql.user set user = 'testuser5' where user = 'testuser1';

从库会同步

第四种情况

grant all on [i].[/i] to testnowild@'%' identified by 'ge0513.hudie';

从库会同步

第二大类:

Replicate_Wild_Ignore_Table: mysql.%

第五种情况

主库:

use test

update mysql.user set user = 'testuser1' where user = 'testuser5';

从库没有同步。坑!

第六种情况

主库:

grant all on [i].[/i] to testwild@'%' identified by 'ge0513.hudie';

从库没有同步。坑!

在复制中,如果实在要启用参数 replicate-ignore-db / replicate-do-db 后想要让复制正常运行,只需在连接数据库后不执行 "use db" 语句即可,如果是在php中,连接数据库后,不再执行 mysql_select_db() 即可。

这是因为复制机制会判断是否使用了 replicate-do(ignore)-db 参数,然后判断当前数据库是否为指定的数据库,如果是,才执行相应的binlog,否则略过。如果不指定数据库的话,就可以忽略这个环节了。

文章参考:链接1 链接2 收起阅读 »

Mysql安装:/bin/rm: cannot remove `libtoolt': No such file or directory

编译MySQL的过程中提示:

/bin/rm: cannot remove `libtoolt': No such file or directory

解决:

1、确认libtool是否已经安装,如果没有安装的话,则先安装libtool

# yum -y install libtool2、分别执行以下三条命令:

# autoreconf --force --install再重新编译安装,问题解决!

# libtoolize --automake --force

# automake --force --add-missing

在网上也看到有别的办法,但是我没有测试过,例如:

这时直接打开 configure,把 $RM “$cfgfile” 那行删除掉,重新再运行 ./configure 就可以了。 收起阅读 »

reids 故障 'I/O error trying to sync with MASTER: connection lost'

现象:

业务出现告警,业务未处理数量增加,发现连接reids很慢。然后再去PING redis机器发现 内网PING redis server 延迟很高 1000ms以上.

排查过程:

- []换网线不起作用。发现网卡一直在100M左右,然后又发现网卡口协商的是百兆,可能是交换机的问题[/][]为什么会有100M的流量呢。redis 主从之间流量异常 查看redis log 的时候可以看到[/]

[2325] 25 Dec 14:55:32.400 * MASTER SLAVE sync started3、从redis不停的去从主上同步数据,但一直lost

[2325] 25 Dec 14:55:32.400 * Non blocking connect for SYNC fired the event.

[2325] 25 Dec 14:55:32.433 * Master replied to PING, replication can continue...

[2325] 25 Dec 14:55:32.447 * Partial resynchronization not possible (no cached master)

[2325] 25 Dec 14:55:32.457 * Full resync from master: de89c0fdb8ecf70677585245f69ad956a4275102:33404969647192

[2325] 25 Dec 14:56:37.159 * MASTER SLAVE sync: receiving 3609059211 bytes from master

[2325] 25 Dec 14:59:12.193 # I/O error trying to sync with MASTER: connection lost

4、为什么LOST呢。 google了一下

client-output-buffer-limit 这个参数对slave 同步时候所用的buffer做限制了5、这里有个插曲。

默认值是这个 client-output-buffer-limit slave 256mb 64mb 60(这是说负责发数据给slave的client,如果buffer超过256m或者连续60秒超过64m,就会被立刻强行关闭!!! Traffic大的话一定要设大一点。否则就会出现一个很悲剧循环,Master传输一个大的RDB给Slave,Slave努力的装载,但还没装载 完,Master对client的缓存满了,再来一次。)

因为redis不能重启。要用命令config set client-output-buffer-limit 这个命令 因为我用的是telnet在设置config set client-output-buffer-limit ‘slave 536870912 134217728 120′ 这样一直不成功。报参数不正确收起阅读 »

Wrong number of arguments for CONFIG SET”

用redis-cli 就正常,应该是空格的问题,不细查了。

有将近9个GB的数据redis_master,然后设置成 ‘slave 536870912 134217728 120’还是同步失败,最后设置成了confg set client-output-buffer-limit ‘slave 2036870912 1534217728 300’就成功了,所以这个设置还得根据你同步数据的多少有针对性的设定。

mysql索引详解

什么是索引

索引用来快速地寻找那些具有特定值的记录,所有MySQL索引都以B-树的形式保存。如果没有索引,执行查询时MySQL必须从第一个记录开始扫描整个表的所有记录,直至找到符合要求的记录。表里面的记录数量越多,这个操作的代价就越高。

如果作为搜索条件的列上已经创建了索引,MySQL无需扫描任何记录即可迅速得到目标记录所在的位置。如果表有1000个记录,通过索引查找记录至少要比顺序扫描记录快100倍。

假设我们创建了一个名为people的表:

CREATE TABLE people ( peopleid SMALLINT NOT NULL, name CHAR(50) NOT NULL );

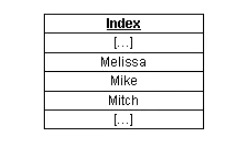

然后,我们完全随机把1000个不同name值插入到people表。下图显示了people表所在数据文件的一小部分:

可以看到,在数据文件中name列没有任何明确的次序。如果我们创建了name列的索引,MySQL将在索引中排序name列:

对于索引中的每一项,MySQL在内部为它保存一个数据文件中实际记录所在位置的“指针”。因此,如果我们要查找name等于“Mike”记录的peopleid(SQL命令为SELECT peopleid FROM people WHERE name='Mike';),MySQL能够在name的索引中查找“Mike”值,然后直接转到数据文件中相应的行,准确地返回该行的peopleid(999)。

在这个过程中,MySQL只需处理一个行就可以返回结果。如果没有“name”列的索引,MySQL要扫描数据文件中的所有记录,即1000个记录!显然,需要MySQL处理的记录数量越少,则它完成任务的速度就越快。

索引的类型

MySQL提供多种索引类型供选择,下面详解每种索引。

普通索引

这是最基本的索引类型,而且它没有唯一性之类的限制。普通索引可以通过以下几种方式创建:

- 创建索引,例如CREATE INDEX <索引的名字> ON tablename (列的列表);

- 修改表,例如ALTER TABLE tablename ADD INDEX [索引的名字] (列的列表);

- 创建表的时候指定索引,例如CREATE TABLE tablename ( […], INDEX [索引的名字] (列的列表) );

唯一性索引

这种索引和前面的“普通索引”基本相同,但有一个区别:索引列的所有值都只能出现一次,即必须唯一。唯一性索引可以用以下几种方式创建:

- 创建索引,例如CREATE UNIQUE INDEX <索引的名字> ON tablename (列的列表);

- 修改表,例如ALTER TABLE tablename ADD UNIQUE [索引的名字] (列的列表);

- 创建表的时候指定索引,例如CREATE TABLE tablename ( […], UNIQUE [索引的名字] (列的列表) );

主键

主键是一种唯一性索引,但它必须指定为PRIMARY KEY。如果你曾经用过AUTO_INCREMENT类型的列,你可能已经熟悉主键之类的概念了。

主键一般在创建表的时候指定,例如CREATE TABLE tablename ( [...], PRIMARY KEY (列的列表) );。但是,我们也可以通过修改表的方式加入主键,例如ALTER TABLE tablename ADD PRIMARY KEY (列的列表);。每个表只能有一个主键。

全文索引

MySQL从3.23.23版开始支持全文索引和全文检索。在MySQL中,全文索引的索引类型为FULLTEXT。全文索引可以在VARCHAR或者TEXT类型的列上创建。它可以通过CREATE TABLE命令创建,也可以通过ALTER TABLE或CREATE INDEX命令创建。对于大规模的数据集,通过ALTER TABLE(或者CREATE INDEX)命令创建全文索引要比把记录插入带有全文索引的空表更快。本文下面的讨论不再涉及全文索引,要了解更多信息,请参见MySQL documentation 。

单列索引与多列索引

索引可以是单列索引,也可以是多列索引。下面我们通过具体的例子来说明这两种索引的区别。假设有这样一个people表:

CREATE TABLE people (

peopleid SMALLINT NOT NULL AUTO_INCREMENT,

firstname CHAR(50) NOT NULL,

lastname CHAR(50) NOT NULL,

age SMALLINT NOT NULL,

townid SMALLINT NOT NULL,

PRIMARY KEY (peopleid) );

下面是我们插入到这个people表的数据:

这个数据片段中有四个名字为Mikes的人(其中两个姓Sullivans,两个姓McConnells),有两个年龄为17岁的人,还有一个名字与众不同的Joe Smith。

这个表的主要用途是根据指定的用户姓、名以及年龄返回相应的peopleid。例如,我们可能需要查找姓名为Mike Sullivan、年龄17岁用户的peopleid(SQL命令为SELECT peopleid FROM people WHERE firstname='Mike' AND lastname='Sullivan' AND age=17;)。由于我们不想让MySQL每次执行查询就去扫描整个表,这里需要考虑运用索引。

首先,我们可以考虑在单个列上创建索引,比如firstname、lastname或者age列。如果我们创建firstname列的索引(ALTER TABLE people ADD INDEX firstname (firstname);),MySQL将通过这个索引迅速把搜索范围限制到那些firstname='Mike'的记录,然后再在这个中间结果集上进行其他条件的搜索:它首先排除那些lastname不等于Sullivan的记录,然后排除那些age不等于17的记录。当记录满足所有搜索条件之后,MySQL就返回最终的搜索结果。

由于建立了firstname列的索引,与执行表的完全扫描相比,MySQL的效率提高了很多,但我们要求MySQL扫描的记录数量仍旧远远超过了实际所需要的。虽然我们可以删除firstname列上的索引,再创建lastname或者age列的索引,但总地看来,不论在哪个列上创建索引搜索效率仍旧相似。

为了提高搜索效率,我们需要考虑运用多列索引。如果为firstname、lastname和age这三个列创建一个多列索引,MySQL只需一次检索就能够找出正确的结果!下面是创建这个多列索引的SQL命令:

ALTER TABLE people ADD INDEX fname_lname_age (firstname,lastname,age);

由于索引文件以B-Tree格式保存,MySQL能够立即转到合适的firstname,然后再转到合适的lastname,最后转到合适的age。在没有扫描数据文件任何一个记录的情况下,MySQL就正确地找出了搜索的目标记录!

那么,如果在firstname、lastname、age这三个列上分别创建单列索引,效果是否和创建一个firstname、lastname、age的多列索引一样呢?答案是否定的,两者完全不同。当我们执行查询的时候,MySQL只能使用一个索引。如果你有三个单列的索引,MySQL会试图选择一个限制最严格的索引。但是,即使是限制最严格的单列索引,它的限制能力也肯定远远低于firstname、lastname、age这三个列上的多列索引。

最左前缀

多列索引还有另外一个优点,它通过称为最左前缀(Leftmost Prefixing)的概念体现出来。继续考虑前面的例子,现在我们有一个firstname、lastname、age列上的多列索引,我们称这个索引为fname_lname_age。当搜索条件是以下各种列的组合时,MySQL将使用fname_lname_age索引:

firstname,lastname,age

firstname,lastname

firstname

从另一方面理解,它相当于我们创建了(firstname,lastname,age)、(firstname,lastname)以及(firstname)这些列组合上的索引。下面这些查询都能够使用这个fname_lname_age索引:

SELECT peopleid FROM people WHERE firstname='Mike' AND lastname='Sullivan' AND age='17';

SELECT peopleid FROM people WHERE firstname='Mike' AND lastname='Sullivan';

SELECT peopleid FROM people WHERE firstname='Mike';

The following queries cannot use the index at all:

SELECT peopleid FROM people WHERE lastname='Sullivan';

SELECT peopleid FROM people WHERE age='17';

SELECT peopleid FROM people WHERE lastname='Sullivan' AND age='17';

选择索引列

在性能优化过程中,选择在哪些列上创建索引是最重要的步骤之一。可以考虑使用索引的主要有两种类型的列:在WHERE子句中出现的列,在join子句中出现的列。请看下面这个查询:

SELECT age # 不使用索引

FROM people WHERE firstname='Mike' # 考虑使用索引

AND lastname='Sullivan' # 考虑使用索引

这个查询与前面的查询略有不同,但仍属于简单查询。由于age是在SELECT部分被引用,MySQL不会用它来限制列选择操作。因此,对于这个查询来说,创建age列的索引没有什么必要。下面是一个更复杂的例子:

SELECT people.age, #不使用索引

town.name #不使用索引

FROM people LEFT JOIN town ON

people.townid=town.townid #考虑使用索引

WHERE firstname='Mike' #考虑使用索引

AND lastname='Sullivan' #考虑使用索引

与前面的例子一样,由于firstname和lastname出现在WHERE子句中,因此这两个列仍旧有创建索引的必要。除此之外,由于town表的townid列出现在join子句中,因此我们需要考虑创建该列的索引。

那么,我们是否可以简单地认为应该索引WHERE子句和join子句中出现的每一个列呢?差不多如此,但并不完全。我们还必须考虑到对列进行比较的操作符类型。MySQL只有对以下操作符才使用索引:<,<=,=,>,>=,BETWEEN,IN,以及某些时候的LIKE。可以在LIKE操作中使用索引的情形是指另一个操作数不是以通配符(%或者_)开头的情形。例如,SELECT peopleid FROM people WHERE firstname LIKE 'Mich%';这个查询将使用索引,但SELECT peopleid FROM people WHERE firstname LIKE '%ike';这个查询不会使用索引。

分析索引效率

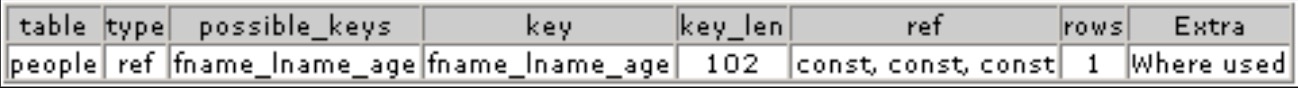

现在我们已经知道了一些如何选择索引列的知识,但还无法判断哪一个最有效。MySQL提供了一个内建的SQL命令帮助我们完成这个任务,这就是EXPLAIN命令。EXPLAIN命令的一般语法是:EXPLAIN 。你可以在MySQL文档找到有关该命令的更多说明。下面是一个例子:

EXPLAIN SELECT peopleid FROM people WHERE firstname='Mike' AND lastname='Sullivan' AND age='17';

这个命令将返回下面这种分析结果:

下面我们就来看看这个EXPLAIN分析结果的含义:

table:这是表的名字。

type:连接操作的类型。下面是MySQL文档关于ref连接类型的说明:

对于每一种与另一个表中记录的组合,MySQL将从当前的表读取所有带有匹配索引值的记录。如果连接操作只使用键的最左前缀,或者如果键不是UNIQUE或PRIMARY KEY类型(换句话说,如果连接操作不能根据键值选择出唯一行),则MySQL使用ref连接类型。如果连接操作所用的键只匹配少量的记录,则ref是一种好的连接类型。

在本例中,由于索引不是UNIQUE类型,ref是我们能够得到的最好连接类型。

如果EXPLAIN显示连接类型是“ALL”,而且你并不想从表里面选择出大多数记录,那么MySQL的操作效率将非常低,因为它要扫描整个表。你可以加入更多的索引来解决这个问题。预知更多信息,请参见MySQL的手册说明。

possible_keys: 可能可以利用的索引的名字。这里的索引名字是创建索引时指定的索引昵称;如果索引没有昵称,则默认显示的是索引中第一个列的名字(在本例中,它是firstname)。默认索引名字的含义往往不是很明显。

Key: 它显示了MySQL实际使用的索引的名字。如果它为空(或NULL),则MySQL不使用索引。

key_len: 索引中被使用部分的长度,以字节计。在本例中,key_len是102,其中firstname占50字节,lastname占50字节,age占2字节。如果MySQL只使用索引中的firstname部分,则key_len将是50。

ref: 它显示的是列的名字(或单词const),MySQL将根据这些列来选择行。在本例中,MySQL根据三个常量选择行。

rows:MySQL所认为的它在找到正确的结果之前必须扫描的记录数。显然,这里最理想的数字就是1。

Extra: 这里可能出现许多不同的选项,其中大多数将对查询产生负面影响。在本例中,MySQL只是提醒我们它将用WHERE子句限制搜索结果集。

索引的缺点

到目前为止,我们讨论的都是索引的优点,事实上,索引也是有缺点的,如下:

首先,索引要占用磁盘空间。通常情况下,这个问题不是很突出。但是,如果你创建每一种可能列组合的索引,索引文件体积的增长速度将远远超过数据文件。如果你有一个很大的表,索引文件的大小可能达到操作系统允许的最大文件限制。

第二,对于需要写入数据的操作,比如DELETE、UPDATE以及INSERT操作,索引会降低它们的速度。这是因为MySQL不仅要把改动数据写入数据文件,而且它还要把这些改动写入索引文件。

总结

在大型数据库中,索引是提高速度的一个关键因素。不管表的结构是多么简单,一次500000行的表扫描操作无论如何不会快。如果你的网站上也有这种大规模的表,那么你确实应该花些时间去分析可以采用哪些索引,并考虑是否可以改写查询以优化应用。要了解更多信息,请参见MySQL manual。

收起阅读 »mysql创建和删除表

简单的方式:

CREATE TABLE person (或者是

number INT(11),

name VARCHAR(255),

birthday DATE

);

CREATE TABLE IF NOT EXISTS person (

number INT(11),

name VARCHAR(255),

birthday DATE

);

查看mysql创建表:

> SHOW CREATE table person;

CREATE TABLE `person` (

`number` int(11) DEFAULT NULL,

`name` varchar(255) DEFAULT NULL,

`birthday` date DEFAULT NULL

) ENGINE=MyISAM DEFAULT CHARSET=utf8;

查看表所有的列:

> SHOW FULL COLUMNS from person;

+----------+--------------+-----------------+------+-----+---------+-------+---------------------------------+---------+

| Field | Type | Collation | Null | Key | Default | Extra | Privileges | Comment |

+----------+--------------+-----------------+------+-----+---------+-------+---------------------------------+---------+

| number | int(11) | NULL | YES | | NULL | | select,insert,update,references | |

| name | varchar(255) | utf8_general_ci | YES | | NULL | | select,insert,update,references | |

| birthday | date | NULL | YES | | NULL | | select,insert,update,references | |

+----------+--------------+-----------------+------+-----+---------+-------+---------------------------------+---------+

创建临时表

CREATE TEMPORARY TABLE temp_person (

number INT(11),

name VARCHAR(255),

birthday DATE

);

在创建表格时,您可以使用TEMPORARY关键词。只有在当前连接情况下,TEMPORARY表才是可见的。当连接关闭时,TEMPORARY表被自动取消。这意味着两个不同的连接可以使用相同的临时表名称,同时两个临时表不会互相冲突,也不与原有的同名的非临时表冲突。(原有的表被隐藏,直到临时表被取消时为止。)您必须拥有CREATE TEMPORARY TABLES权限,才能创建临时表。

如果表已存在,则使用关键词IF NOT EXISTS可以防止发生错误。

CREATE TABLE IF NOT EXISTS person2 (

number INT(11),

name VARCHAR(255),

birthday DATE

);

注意,原有表的结构与CREATE TABLE语句中表示的表的结构是否相同,这一点没有验证。注释:如果您在CREATE TABLE...SELECT语句中使用IF NOT EXISTS,则不论表是否已存在,由SELECT部分选择的记录都会被插入

在CREATE TABLE语句的末尾添加一个SELECT语句,在一个表的基础上创建表

CREATE TABLE new_tbl SELECT [i] FROM orig_tbl;注意,用SELECT语句创建的列附在表的右侧,而不是覆盖在表上mysql> SELECT [/i] FROM foo;也可以明确地为一个已生成的列指定类型

+---+

| n |

+---+

| 1 |

+---+

mysql> CREATE TABLE bar (m INT) SELECT n FROM foo;

mysql> SELECT * FROM bar;

+------+---+

| m | n |

+------+---+

| NULL | 1 |

+------+---+

CREATE TABLE foo (a TINYINT NOT NULL) SELECT b+1 AS a FROM bar;根据其它表的定义(包括在原表中定义的所有的列属性和索引),使用LIKE创建一个空表:

CREATE TABLE new_tbl LIKE orig_tbl;创建一个有主键,唯一索引,普通索引的表:

CREATE TABLE `people` (其中peopleid是主键,以firstname和lastname两列建立了一个唯一索引,以firstname,lastname,age三列建立了一个普通索引

`peopleid` smallint(6) NOT NULL AUTO_INCREMENT,

`firstname` char(50) NOT NULL,

`lastname` char(50) NOT NULL,

`age` smallint(6) NOT NULL,

`townid` smallint(6) NOT NULL,

PRIMARY KEY (`peopleid`),

UNIQUE KEY `unique_fname_lname`(`firstname`,`lastname`),

KEY `fname_lname_age` (`firstname`,`lastname`,`age`)

) ;

删除表

DROP TABLE tbl_name;

或者是

DROP TABLE IF EXISTS tbl_name;

清空表数据收起阅读 »

TRUNCATE TABLE table_name

Elasticsearch 分片交互过程详解

一、Elasticseach如何将数据存储到分片中

问题:当我们要在ES中存储数据的时候,数据应该存储在主分片和复制分片中的哪一个中去;当我们在ES中检索数据的时候,又是怎么判断要查询的数据是属于哪一个分片。

数据存储到分片的过程是一定规则的,并不是随机发生的。

规则:shard = hash(routing) % number_of_primary_shards

Routing值可以是一个任意的字符串,默认情况下,它的值为存数数据对应文档 _id 值,也可以是用户自定义的值。Routing这个字符串通过一个hash的函数处理,并返回一个数值,然后再除以索引中主分片的数目,所得的余数作为主分片的编号,取值一般在0到number_of_primary_shards - 1的这个范围中。通过这种方法计算出该数据是存储到哪个分片中。

正是这种路由机制,导致了主分片的个数为什么在索引建立之后不能修改。对已有索引主分片数目的修改直接会导致路由规则出现严重问题,部分数据将无法被检索。

二、主分片与复制分片如何交互

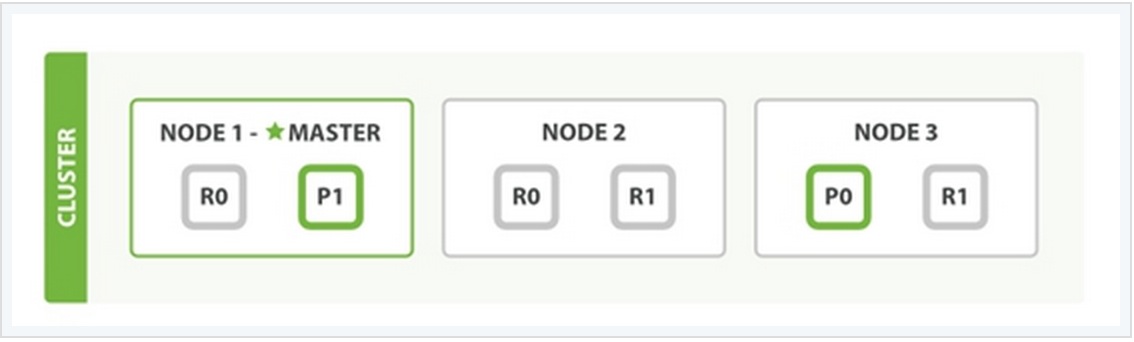

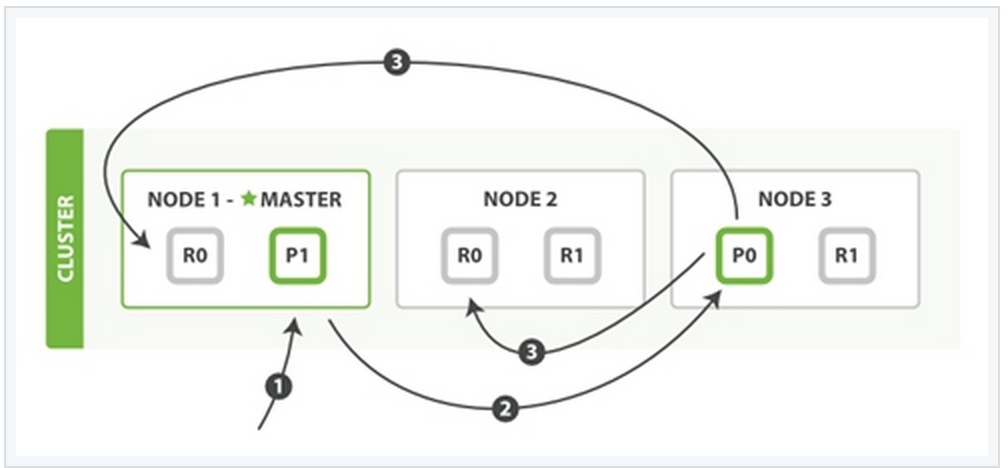

为了说明这个问题,我用一个例子来说明。

在上面这个例子中,有三个ES的node,其中每一个index中包含两个primary shard,每个primary shard拥有2个replica shard。下面从几种常见的数据操作来说明二者之间的交互情况。

1、索引与删除一个文档

这两种过程均可以分为三个过程来描述:

阶段1:客户端发送了一个索引或者删除的请求给node 1。

阶段2:node 1通过请求中文档的 _id 值判断出该文档应该被存储在shard 0 这个分片中,并且node 1知道shard 0的primary shard位于node 3这个节点上。因此node 1会把这个请求转发到node 3。

阶段3:node 3在shard 0 的primary shard上执行请求。如果请求执行成功,它node 3将并行地将该请求发给shard 0的其余所有replica shard上,也就是存在于node 1和node 2中的replica shard。如果所有的replica shard都成功地执行了请求,那么将会向node 3回复一个成功确认,当node 3收到了所有replica shard的确认信息后,则最后向用户返回一个Success的消息。

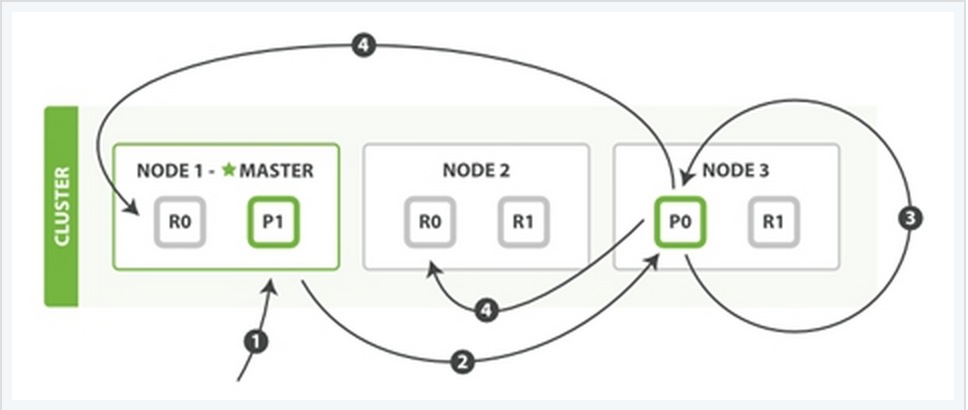

2、更新一个文档

该过程可以分为四个阶段来描述:

阶段1:客户端向node 1发送一个文档更新的请求。

阶段2:同样的node 1通过请求中文档的 _id 值判断出该文档应该被存储在shard 0 这个分片中,并且node 1知道shard 0的primary shard位于node 3这个节点上。因此node 1会把这个请求转发到node 3。

阶段3:node 3从文档所在的primary shard中获取到它的JSON文件,并修改其中的_source中的内容,之后再重新索引该文档到其primary shard中。

阶段4:如果node 3成功地更新了文档,node 3将会把文档新的版本并行地发给其余所有的replica shard所在node中。这些node也同样重新索引新版本的文档,执行后则向node 3确认成功,当node 3接收到所有的成功确认之后,再向客户端发送一个更新成功的信息。

3、检索文档

CRUD这些操作的过程中一般都是结合一些唯一的标记例如:_index,_type,以及routing的值,这就意味在执行操作的时候都是确切的知道文档在集群中的哪个node中,哪个shard中。

而检索过程往往需要更多的执行模式,因为我们并不清楚所要检索的文档具体位置所在, 它们可能存在于ES集群中个任何位置。因此,一般情况下,检索的执行不得不去询问index中的每一个shard。

但是,找到所有匹配检索的文档仅仅只是检索过程的一半,在向客户端返回一个结果列表之前,必须将各个shard发回的小片的检索结果,拼接成一个大的已排好序的汇总结果列表。正因为这个原因,检索的过程将分为查询阶段与获取阶段(Query Phase and Fetch Phase)。

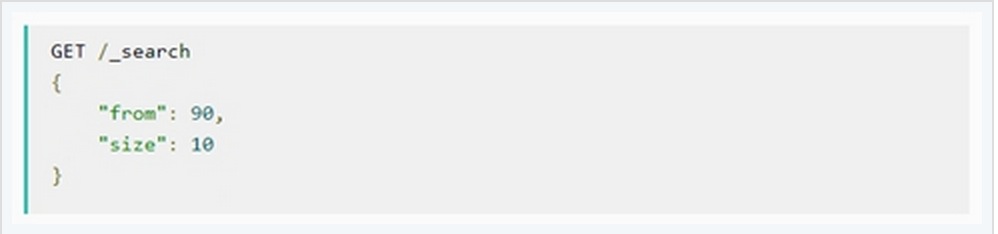

Query Phase

在最初的查询过程中,查询请求会广播到index中的每一个primary shard和replica shard中,每一个shard会在本地执行检索,并建立一个优先级队列(priority queue)。这个优先级队列是一个根据文档匹配度这个指标所排序列表,列表的长度由分页参数from和size两个参数所决定。例如:

下面从一个例子中说明这个过程:

Query Phase阶段可以再细分成3个小的子阶段:

子阶段1:客户端发送一个检索的请求给node 3,此时node 3会创建一个空的优先级队列并且配置好分页参数from与size。

子阶段2:node 3将检索请求发送给该index中个每一个shard(这里的每一个意思是无论它是primary还是replica,它们的组合可以构成一个完整的index数据)。每个shard在本地执行检索,并将结果添加到本地优先级队列中。

子阶段3:每个shard返回本地优先级序列中所记录的_id与sort值,并发送node 3。Node 3将这些值合并到自己的本地的优先级队列中,并做全局的排序。

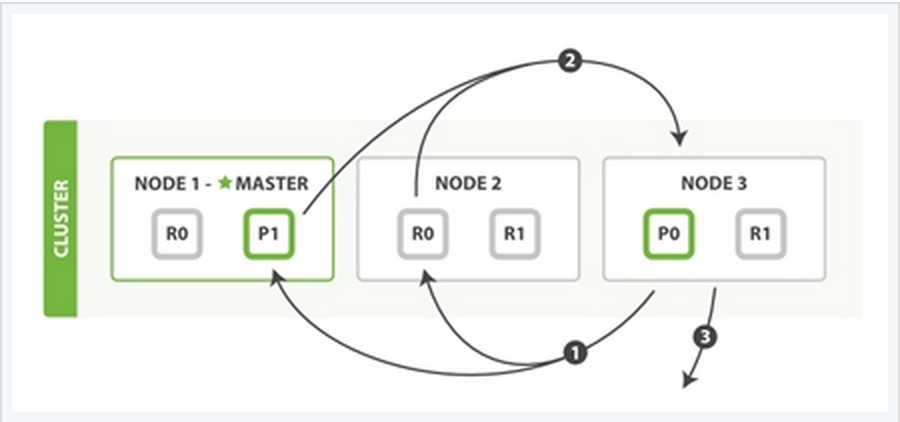

Fetch PhaseQuery Phase主要定位了所要检索数据的具体位置,但是我们还必须取回它们才能完成整个检索过程。而Fetch Phase阶段的任务就是将这些定位好的数据内容取回并返回给客户端。

同样也用一个例子来说明这个过程:

Fetch Phase过程可以分为三个子过程来描述:

子阶段1:node 3获取了所有待检索数据的定位之后,发送一个mget的请求给与数据相关的shard。

子阶段2:每个收到node 3的get请求的shard将读取相关文档_source中的内容,并将它们返回给node 3。

子阶段3:当node 3获取到了所有shard返回的文档后,node 3将它们合并成一条汇总的结果,返回给客户端。

收起阅读 »