通知设置 新通知

Kvm ERROR Guest name 'vhostname' is already in use.

大数据 OpenSkill 发表了文章 0 个评论 5252 次浏览 2015-06-16 09:54

[root@cjlx qemu]# virt-install --name=convirt --ram=512 --vcpus=2 --cpu=core2duo --pxe --os-type=linux --disk path=/data/vm/convirt.img,size=50 --network bridge=br1,model=virtio --network bridge=br0,model=virtio --graphics vnc,password=123456,port=9903 --hvm –force

ERROR Guest name 'convirt' is already in use.

这点kvm和xen不同,xen的半虚拟化要想重装,只要把创建好的虚拟机配置文件删掉就可以了

kvm如果想要重装相同名字的虚拟机,只需要在虚拟机停止的状态下执行如下命令

[root@cjlx qemu]# virsh undefine convirt这样,虚拟机就被干掉了,同样,相应的xml配置文件也干掉了。

Domain convirt has been undefined

然后在执行virt-install安装就不会报错了。

python中xrange和range的异同

编程 OpenSkill 发表了文章 0 个评论 3551 次浏览 2015-06-15 00:48

range

函数说明:range([start,] stop[, step]),根据start与stop指定的范围以及step设定的步长,生成一个序列。

range示例:

>>> range(5)

[0, 1, 2, 3, 4]

[quote]>> range(1,5)

[1, 2, 3, 4]

>>> range(0,6,2)

[0, 2, 4]

xrange

函数说明:用法与range完全相同,所不同的是生成的不是一个数组,而是一个生成器。

xrange示例:

>>> xrange(5)

xrange(5)

>>> list(xrange(5))

[0, 1, 2, 3, 4]

>>> xrange(1,5)

xrange(1, 5)

>>> list(xrange(1,5))

[1, 2, 3, 4]

>>> xrange(0,6,2)

xrange(0, 6, 2)

>>> list(xrange(0,6,2))

[0, 2, 4]

由上面的示例可以知道:要生成很大的数字序列的时候,用xrange会比range性能优很多,因为不需要一上来就开辟一块很大的内存空间,这两个基本上都是在循环的时候用:

for i in range(0, 100):

print i

for i in xrange(0, 100):

print i

这两个输出的结果都是一样的,实际上有很多不同,range会直接生成一个list对象:

a = range(0,100)

print type(a)

print a

print a[0], a[1]

输出结果:

<type 'list'>

[0, 1, 2, 3, 4, 5, 6, 7, 8, 9, 10, 11, 12, 13, 14, 15, 16, 17, 18, 19, 20, 21, 22, 23, 24, 25, 26, 27, 28, 29, 30, 31, 32, 33, 34, 35, 36, 37, 38, 39, 40, 41, 42, 43, 44, 45, 46, 47, 48, 49, 50, 51, 52, 53, 54, 55, 56, 57, 58, 59, 60, 61, 62, 63, 64, 65, 66, 67, 68, 69, 70, 71, 72, 73, 74, 75, 76, 77, 78, 79, 80, 81, 82, 83, 84, 85, 86, 87, 88, 89, 90, 91, 92, 93, 94, 95, 96, 97, 98, 99]

0 1

而xrange则不会直接生成一个list,而是每次调用返回其中的一个值:

a = xrange(0,100)

print type(a)

print a

print a[0], a[1]

输出结果:

<type 'xrange'>

xrange(100)

0 1

【实战】五个Docker监控工具的对比

大数据 OpenSkill 发表了文章 1 个评论 3512 次浏览 2015-06-14 15:58

【编者的话】这篇文章作者是Usman,他是服务器和基础架构工程师,有非常丰富的分布式构建经验。该篇文章主要分析评估了五种Docker监控工具,包括免费的和不免费的:Docker Stats、CAdvisor、Scout、Data Dog以及Sensu。不过作者还是推荐使用Data Dog。另外还有两个工具:Prometheus与Sysdig Cloud会在下一篇做介绍分析,敬请期待。

随着Docker被大规模的部署应用,如何通过可视化的方式了解Docker环境的状态以及健康变得越来越重要。这篇文章我们来回顾下监控容器的常用工具。我会基于以下标准评估这些工具:

- 易于部署

- 信息呈现的详细度

- 整个部署过程中日志的聚集程度

- 数据报警能力

- 是否可以监控非Docker的资源

- 成本

这些评估标准可能并不全面,但是我试图强调的是最常用的工具以及优化此六项评估标准的工具。

Docker Stats命令本文中所有使用的命令只在亚马逊EC2上的RancherOS实例中测试过。但是我想它们应该可以在任何的Docker容器中运行。

我将讨论的第一个工具是Docker本身。你可能不知道Docker客户端已经提供了基本的命令行工具来检查容器的资源消耗。想要查看容器统计信息只需运行

docker stats [CONTAINER_NAME]

这样就可以查看每个容器的CPU利用率、内存的使用量以及可用内存总量。请注意,如果你没有限制容器内存,那么该命令将显示您的主机的内存总量。但它并不意味着你的每个容器都能访问那么多的内存。另外,还可以看啊都容器通过网络发送和接收的数据总量。

$ docker stats determined_shockley determined_wozniak prickly_hypatia

CONTAINER CPU % MEM USAGE/LIMIT MEM % NET I/O

determined_shockley 0.00% 884 KiB/1.961 GiB 0.04% 648 B/648 B

determined_wozniak 0.00% 1.723 MiB/1.961 GiB 0.09% 1.266 KiB/648 B

prickly_hypatia 0.00% 740 KiB/1.961 GiB 0.04% 1.898 KiB/648 B

如果想要看到更为详细的容器属性,还可以通过netcat,使用Docker远程API来查看(见下文)。发送一个HTTP GET请求/containers/[CONTAINER_NAME],其中CONTAINER_NAME是你想要统计的容器名称。你可以从这里看到一个容器stats请求的完整响应信息。在上述的例子中你会得到缓存、交换空间以及内存的详细信息。如果要了解什么是metrics,那么你就需要精读Docker文档的Run Metrics部分。

评分:

- 易于部署程度:※※※※※

- 信息详细程度:※※※※※

- 集成度:无

- 生成警报的能力:无

- 监测非Docker的资源的能力:无

- 成本:免费

CAdvisor我们可以使用docker stats命令和远程API来获取容器的状态信息。但是,如果你想要在图形界面中直接查看这些信息,那你就需要诸如CAdvisor这类的工具。CAdvisor提供了早docker stats命令所显示的数据的可视化界面。运行以下Docker命令,并在浏览器里访问http://<your-hostname>:8080/可以看到CAdvisor的界面。你将看到CPU的使用率、内存使用率、网络吞吐量以及磁盘空间利用率。然后,你可以通过点击在网页顶部的Docker Containers链接,然后选择某个容器来详细了解它的使用情况。

docker run \

--volume=/:/rootfs:ro \

--volume=/var/run:/var/run:rw \

--volume=/sys:/sys:ro \

--volume=/var/lib/docker/:/var/lib/docker:ro \

--publish=8080:8080 \

--detach=true \

--name=cadvisor \

google/cadvisor:latest

CAdvisor是一个易于设置并且非常有用的工具,我们不用非要SSH到服务器才能查看资源消耗,而且它还给我们生成了图表。此外,当集群需要额外的资源时,压力表(pressure gauges )提供了快速预览。而且,与本文中的其他的工具不一样的是CAdvisor是免费的,并且还开源。另外,它的资源消耗也比较低。但是,它有它的局限性,它只能监控一个Docker主机。因此,如果你是多节点的话,那就比较麻烦了,你得在所有的主机上都安装一个CAdvisor,者肯定特别不方便。值得注意的是,如果你使用的是Kubernetes,你可以使用heapster来监控多节点集群。另外,在图表中的数据仅仅是时长一分钟的移动窗口,并没有方法来查看长期趋势。如果资源使用率在危险水平,它却没有生成警告的机制。如果在Docker节点的资源消耗方面,你没有任何可视化界面,那么CAdvisor是一个不错的开端来带你步入容器监控,然而如果你打算在你的容器中运行任何关键任务,那你就需要一个更强大的工具或者方法。

评分:(忽略了heapster,因为它仅支持Kubernetes)

- 易于部署程度:※※※※※

- 信息详细程度:※※

- 集成度:※

- 生成警报的能力:无

- 监测非Docker的资源的能力:无

- 成本:免费

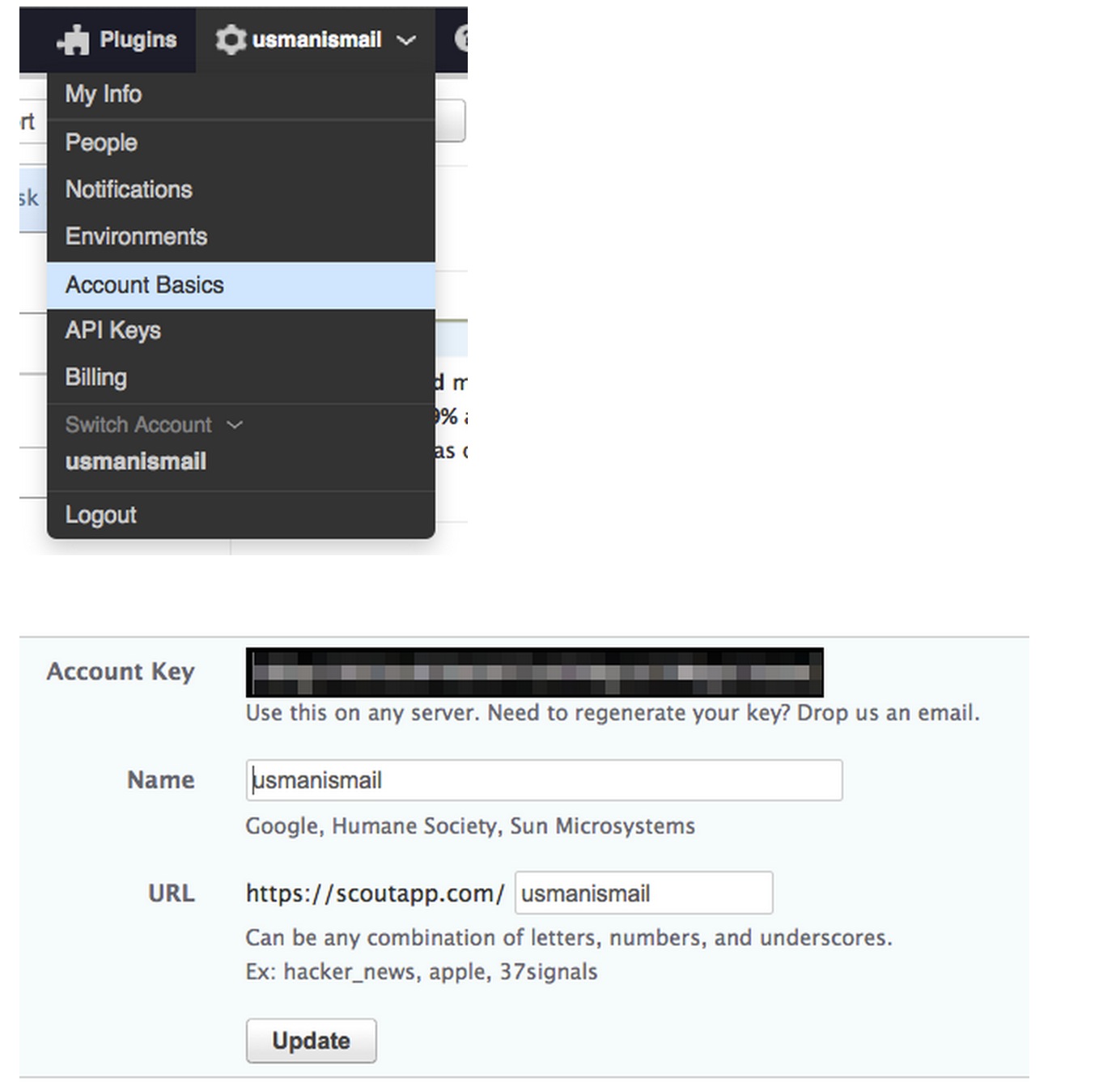

Scout下一个Docker监控的方法是Scout,它解决了CAdvisor的局限性。 Scout是一个应用监控服务,它能够从很多主机和容器中获得各项监测数据,并将数据呈现在有更长时间尺度的图标中。它也可以基于这些指标生成警报。要获取Scout并运行,第一步,在scoutapp.com注册一个Scout帐户,免费的试用账号足以用来集成测试。一旦你创建了自己的帐户并登录,点击右上角的帐户名称,然后点击Account Basics来查看你的Account Key,你需要这个Key从Docker服务器来发送指标。

现在在你的主机上,创建一个名为scouts.yml的文件并将下面的文字复制到该文件中,用上边得到的Key替换到account_key。您可以对主机指定任何有意义的变量:display_name、environment与roles等属性。当他们在scout界面上呈现时,这些将用于分离各种指标。我假设有一组网站服务器列表正在运行Docker,它们都将采用如下图所示的变量。

# account_key is the only required value

account_key: YOUR_ACCOUNT_KEY

hostname: web01-host

display_name: web01

environment: production

roles: web

现在,你可以使用scout配置文件通过Docker-scout插件来运行scout。

docker run -d --name scout-agent \

-v /proc:/host/proc:ro \

-v /etc/mtab:/host/etc/mtab:ro \

-v /var/run/docker.sock:/host/var/run/docker.sock:ro \

-v `pwd`/scoutd.yml:/etc/scout/scoutd.yml \

-v /sys/fs/cgroup/:/host/sys/fs/cgroup/ \

--net=host --privileged \

soutapp/docker-scout

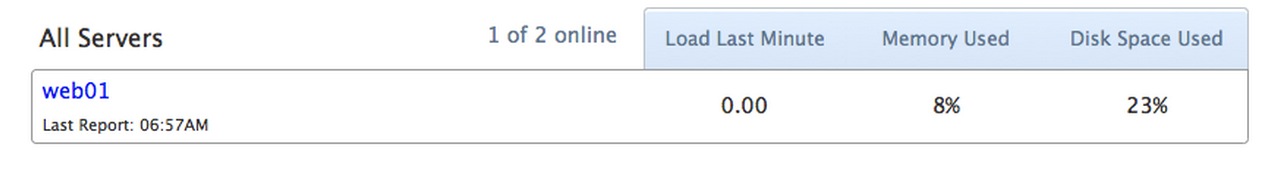

这样你查看Scout网页就能看到一个条目,其中display_name参数(web01)就是你在scoutd.yml里面指定的。

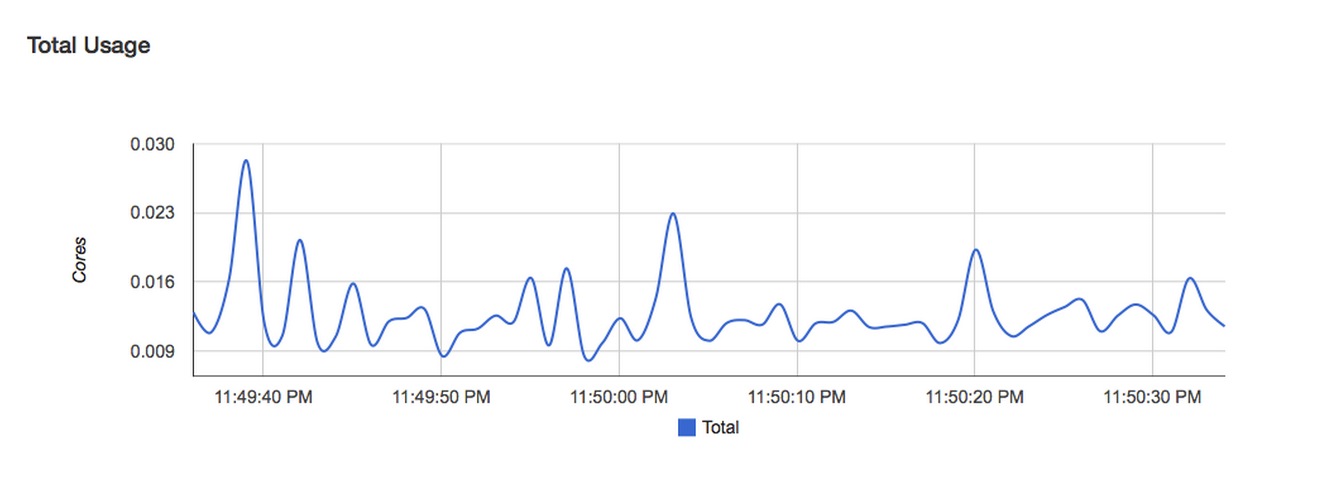

如果你点击它(web01)就会显示主机的详细信息。其中包括任何运行在你主机上的进程计数、cpu使用率以及内存利用率,值得注意的是在docker内部并没有进程的限制。

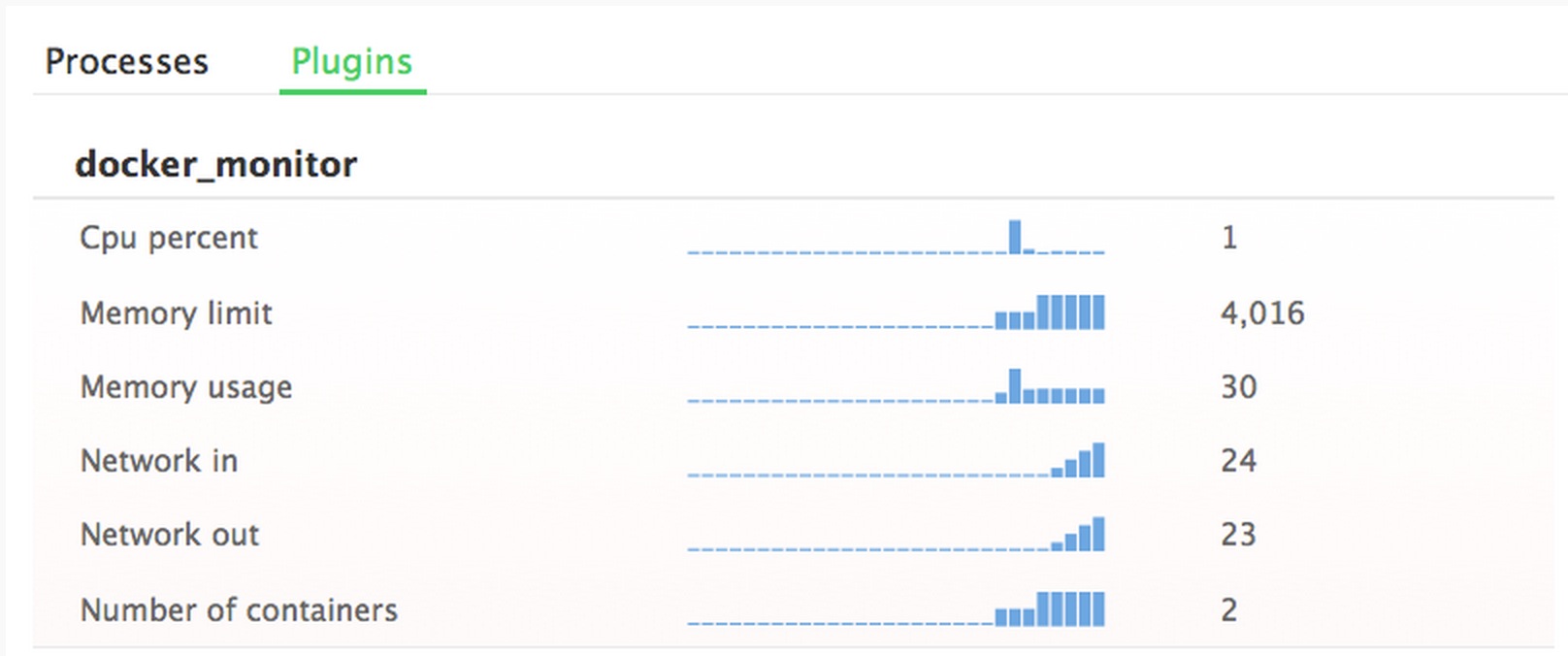

如果要添加Docker监控服务,需要单击Roles选项卡,然后选择所有服务。现在点击+插件模板按钮,接下来的Docker监视器会加载详细信息视图。一旦详细信息呈现出来,选择安装插件来添加到您的主机。接着会给你提供一个已安装插件的名称以及需指定要监视的容器。如果该字段是空的,插件将监控主机上所有的容器。点击完成按钮,一分钟左右你就可以在[Server Name] > Plugins中看到从Docker监控插件中获取的详细信息。该插件为每个主机显示CPU使用率、内存使用率、网络吞吐量以及容器的数量。

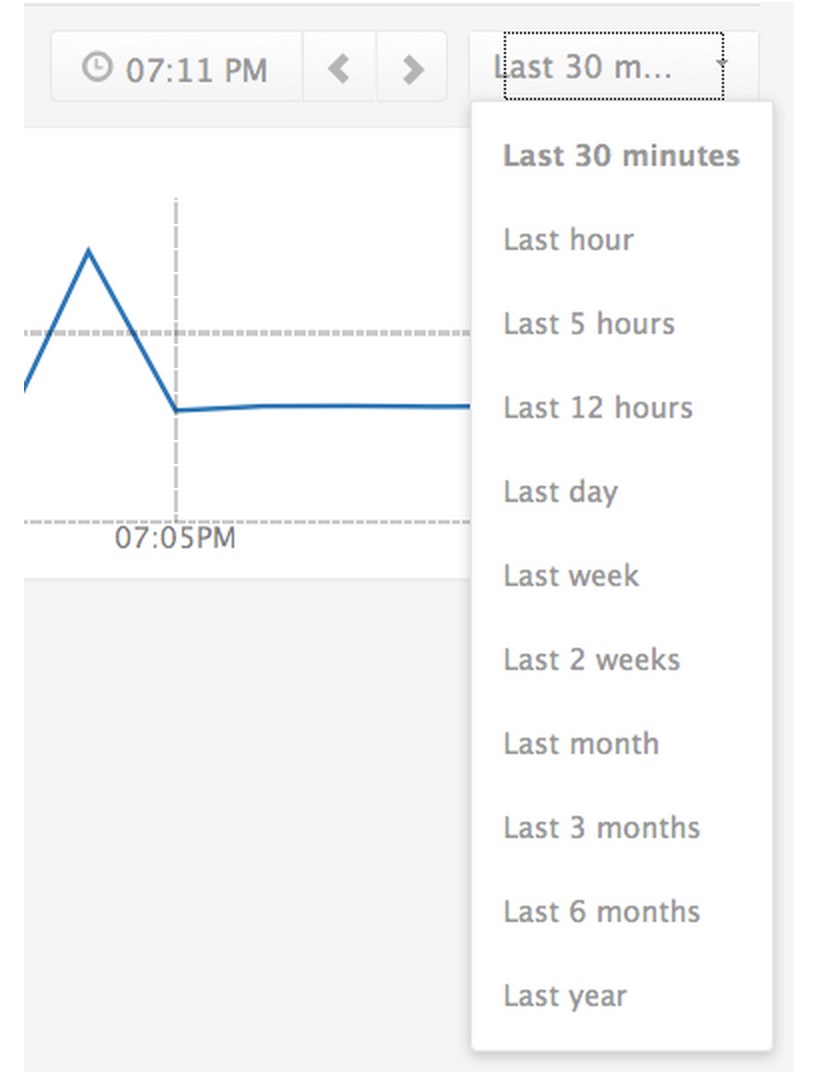

你点击任何一个图表,都可以拉取该指标的详细视图,该视图可以让你看到时间跨度更长的趋势。

该视图还支持过滤基于环境和服务器角色的指标。此外,你可以创建“Triggers”或警报,如果指标高于或低于配置的阈值它就给你发送电子邮件。这就允许您设置自动警报来通知您,比如,如果你的一些容器异常关闭以及容器计数低于一定数量。您还可以设置对平均CPU利用率的警报,举例来说,如果你正在运行的容器超过CPU利用率而发热,你会得到一个警告,当然你可以开启更多的主机到你的Docker集群。

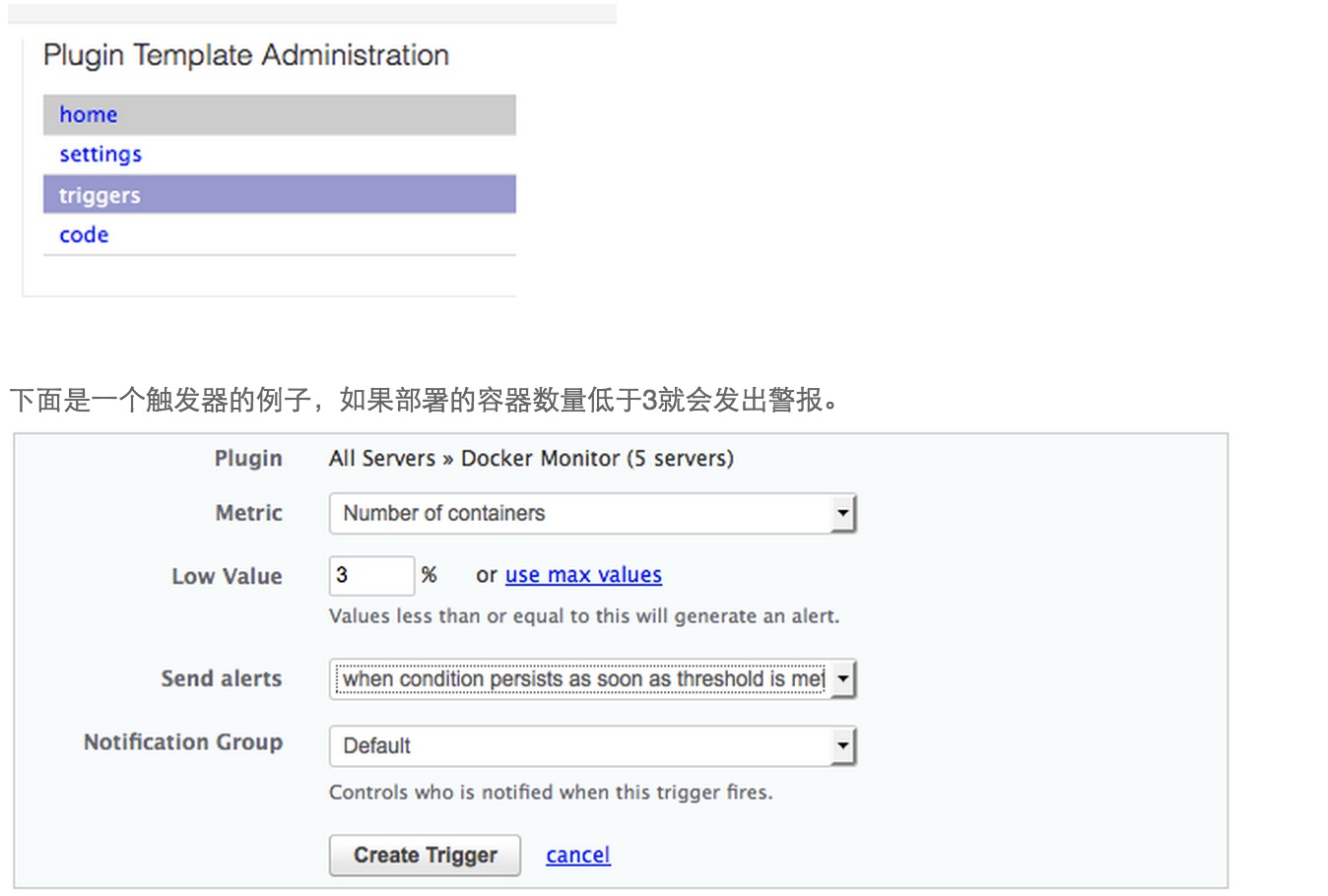

要创建触发器,请选择顶部菜单的Roles>All Servers,然后选择plugins部分的Docker monitor。然后在屏幕的右侧的Plugin template Administration菜单里选择triggers。您现在应该看到一个选项“Add a Trigger”,它将应用到整个部署。

它的创建是为“所有的服务器”,当然你也可以用不同的角色标记你的主机使用服务器上创建的scoutd.yml文件。使用角色。你可以通过使用不同角色来应用触发器到部署的服务器的一个子集上。例如,你可以设置一个当在你的网络的节点的容器数量低于一定数量时的警报。即使是基于角色的触发器我仍然觉得Scout的警报系统可能做的更好。这是因为许多Docker部署具有相同主机上的多种多样的容器。在这种情况下为特定类型的容器设置触发器将是不可能的由于角色被应用到主机上的所有容器。

比起CAdvisor,使用Scout的另一个优点是,它有大量的插件,除了Docker信息他们可以吸收其他有关你的部署的数据。这使得Scout是你的一站式监控系统,而无需对系统的各种资源来安装各种不同的监控系统。

Scout的一个缺点是,它不显示有关每个主机上像CAdvisor的单独容器的详细信息。这是个问题,如果你在同一台服务器上运行大量的容器。例如,如果你想有一个触发器来提醒您的Web容器的警报,但不是Jenkins容器,这时Scout就无法支持该情况。尽管有这个缺点,Scout还是一个相当有用的工具来监控你的Docker部署。当然这要付出一些代价,每个监控的主机十美元。如果你要运行一个有多台主机的超大部署,这个代价会是个考虑因素。

评分:

- 易于部署程度:※※※※

- 信息详细程度:※※

- 集成度:※※※

- 生成警报的能力:※※※

- 监测非Docker的资源的能力:支持

- 成本:每个主机$10

DataDog从Scout移步到另一个监控服务——DataDog,它既解决几个Scout的缺点又解除了CAdvisor的局限性。要使用DataDog,先在https://www.datadoghq.com/注册一个DataDog账户。一旦你登录到您的帐户,您将看到支持集成的每种类型的指令列表。从列表中选择Docker,你会得到一个Docker run命令(如下),将其复制到你的主机。该命令需要你的预先设置的API密钥,然后你可以运行该命令。大约45秒钟后您的代理将开始向DataDog系统报告。

docker run -d --privileged --name dd-agent \

-h `hostname` \

-v /var/run/docker.sock:/var/run/docker.sock \

-v /proc/mounts:/host/proc/mounts:ro \

-v /sys/fs/cgroup/:/host/sys/fs/cgroup:ro \

-e API_KEY=YOUR_API_KEY datadog/docker-dd-agent \

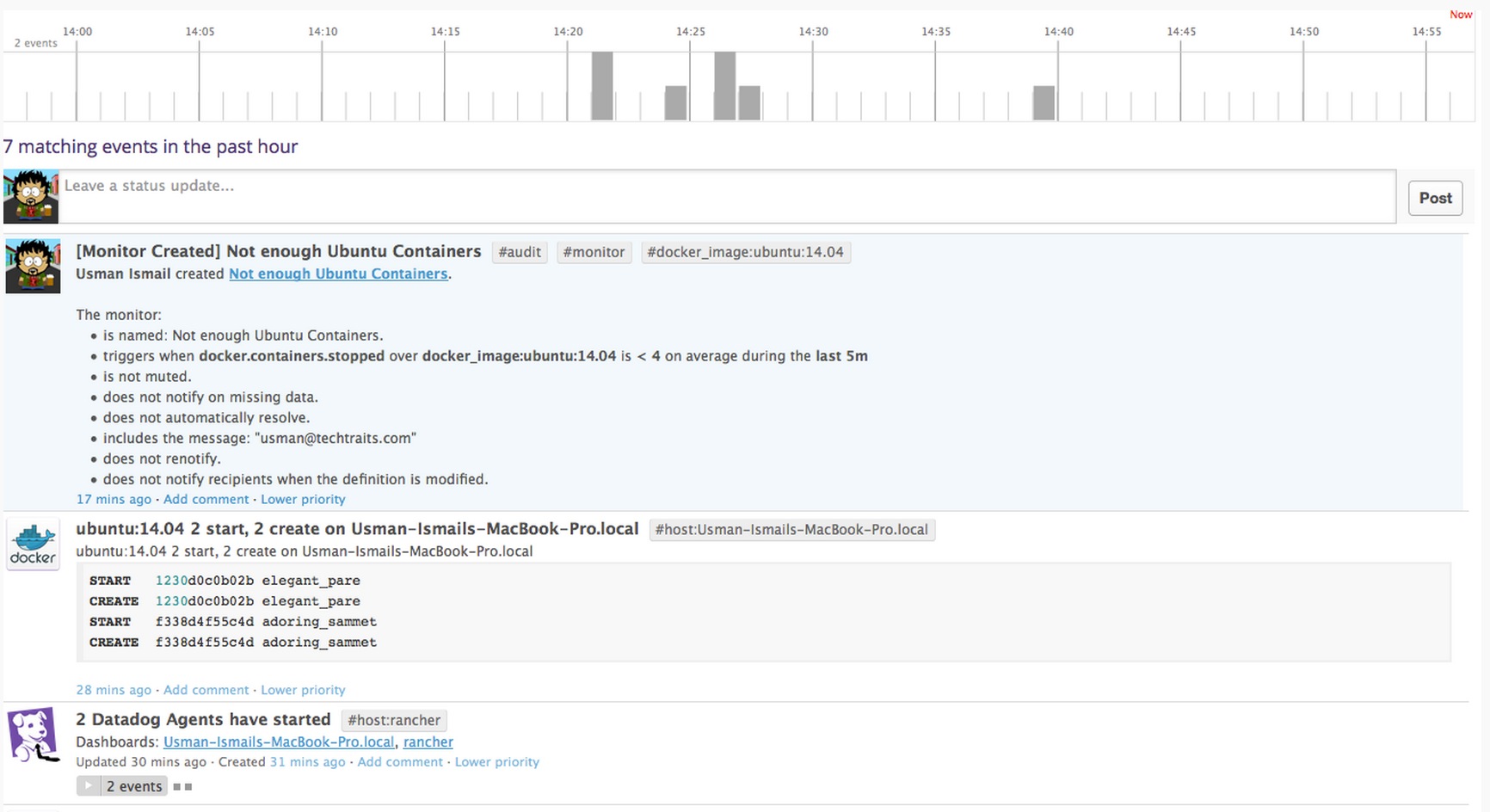

此时,容器提示你可以在DataDog Web的Events tab上处理和查看有关集群的所有动态。所有容器的启动和终止都是事件流的一部分。

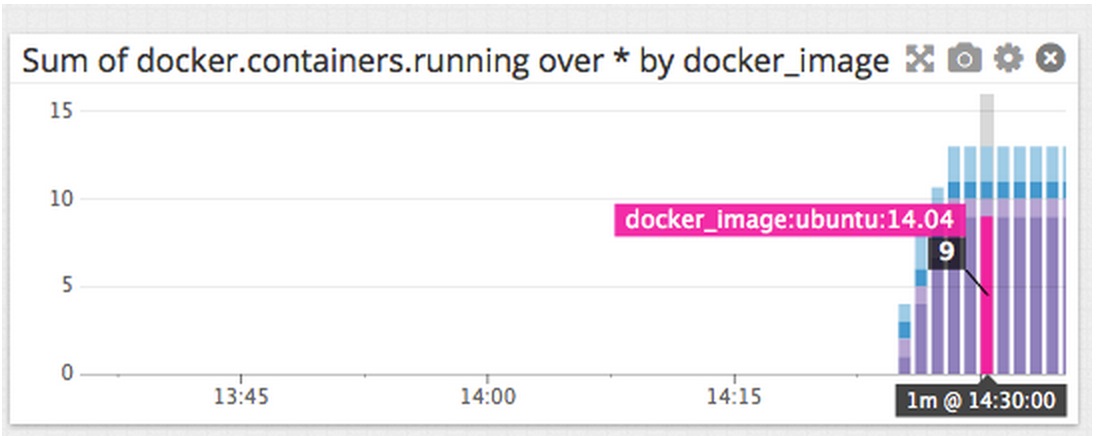

您也可以点击Dashboards标签并点击创建仪表板以合计您整个群集的指标。 Datadog收集在系统中运行的所有容器的CPU使用率、内存以及I/O的指标。此外,也可以获得容器运行和停止次数以及Docker的镜像数量。Dashboard视图可以创建任何数据的图标,或者设置整个部署、主机群、容器镜像指标的图表。例如下图显示了运行容器的数量并加以镜像类型分类,此刻在我的集群运行了9个Ubuntu:14.04的容器。

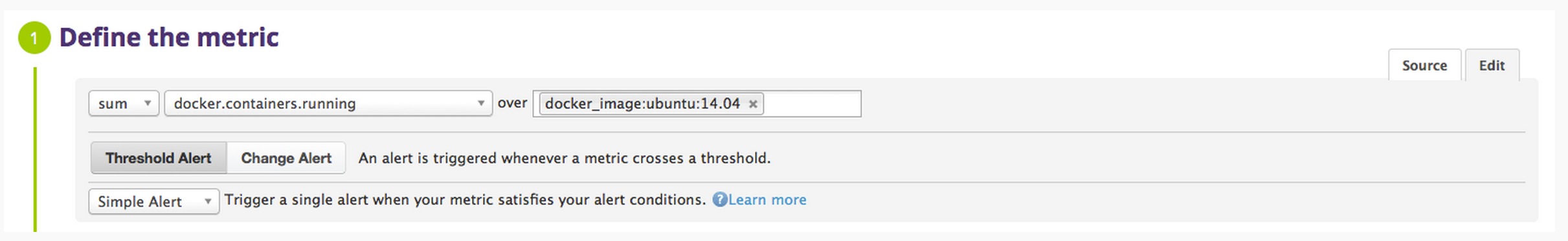

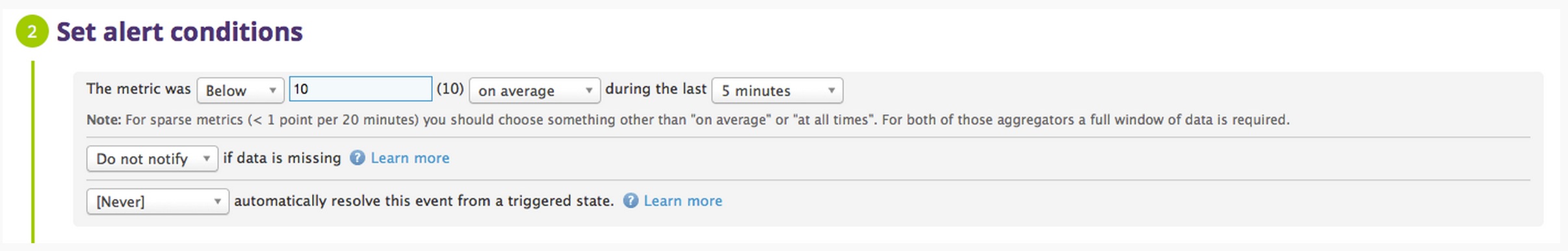

DataDog还支持一种称为Monitors的警报功能。DataDog的一个monitor相当于Scout的一个触发器,并允许您定义各种指标的阈值。 比起Scout,DataDog的警报系统相当灵活与详细。下面的例子说明如何指定您监视的Ubuntu容器的终止,因此你会监视从Ubuntu:14.04的Docker镜象所创建容器的docker.containers.running信息。

然后,特定的警报情况是,如果在我们的部署中最后5分钟有(平均)少于十个Ubuntu容器,你就会被警报。尽管这里没有显示,你会被要求填写发送出去时的指定消息在这个警报被触发后,而且还有受到此警报的目标。在当前的例子中,我用一个简单的绝对阈值。您也可以指定一个基于增量的警报,比如是在最后五分钟里停止的容器的平均计数是四的警报。

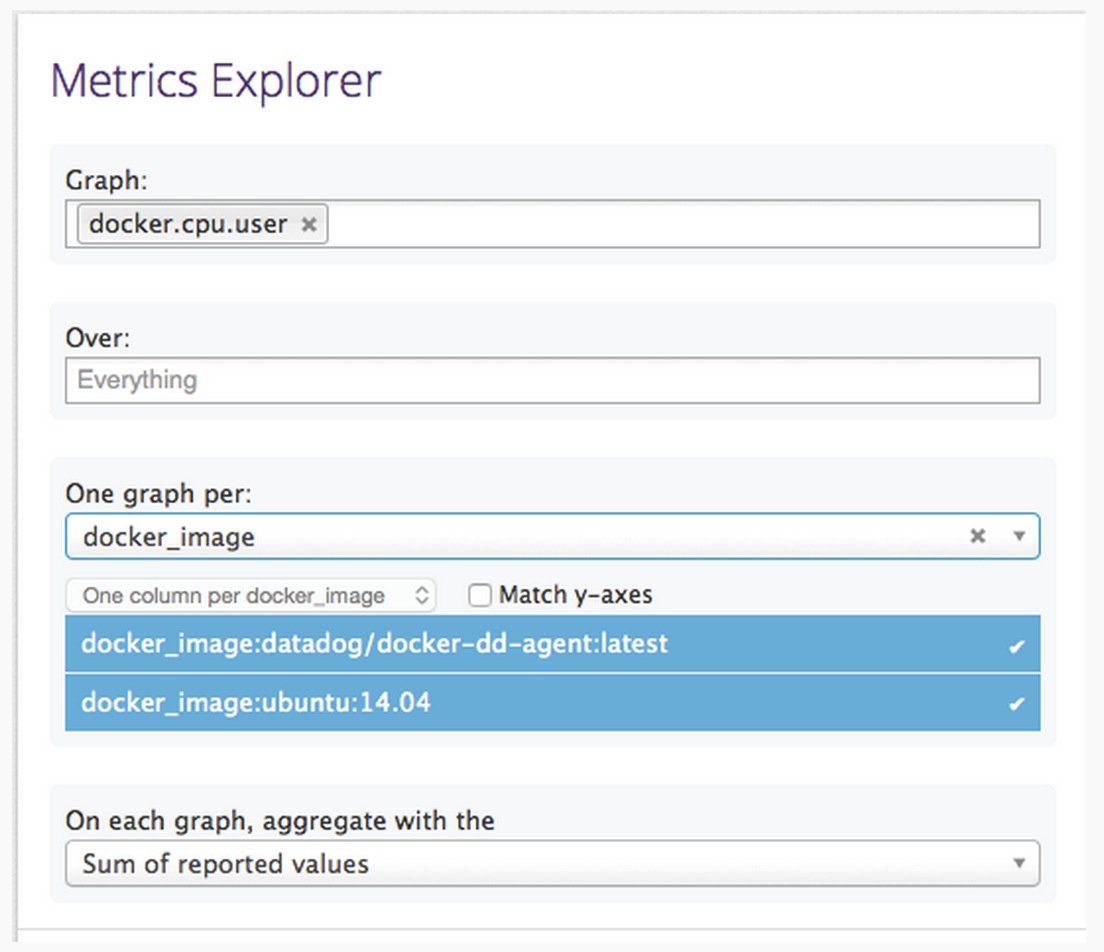

最后,使用Metrics Explorer选项卡可以临时聚集你的指标来帮助调试问题或者提取具体的数据信息。该视图允许您基于对容器镜像或主机绘制任何指标的图表。您可以将输出的数据组合成一个单一的图形或者通过镜像或主机的分组来生成一组图形。

DataDog相比scout在某些功能上做了显著地改善,方便使用以及用户友好的设计。然而这一级别伴随着额外的成本,因为每个DataDog agent价格为$15。

评分:

- 易于部署程度:※※※※※

- 信息详细程度:※※※※※

- 集成度:※※※※※

- 生成警报的能力:支持

- 监测非Docker的资源的能力:※※※※※

- 成本:每个主机$15

Sensu Monitoring FrameworkScout和Datadog提供集中监控和报警系统,然而他们都是被托管的服务,大规模部署的话成本会很突出。如果你需要一个自托管、集中指标的服务,你可以考虑sensu open source monitoring framework。要运行Sensu服务器可以使用hiroakis/docker-sensu-server容器。这个容器会安装sensu-server、uchiwa Web界面、Redis、rabbitmq-server以及sensu-api。不幸的是sensu不支持Docker。但是,使用插件系统,您可以配置支持容器指标以及状态检查。

在开启sensu服务容器之前,你必须定义一个可以加载到服务器中检查。创建一个名为check-docker.json的文件并添加以下内容到此文件。这个文件告诉Sensu服务器在所有有docker标签的客户端上每十秒运行一个名为load-docker-metrics.sh的脚本。

{

"checks": {

"load_docker_metrics": {

"type": "metric",

"command": "load-docker-metrics.sh",

"subscribers": [

"docker"

],

"interval": 10

}

}

}

现在,您可以使用下面的命令通过我们的检查配置文件来运行Sensu服务器Docker容器。一旦你运行该命令,你就可以在浏览器输入http://YOUR_SERVER_IP:3000来访问uchiwa界面。

docker run -d --name sensu-server \

-p 3000:3000 \

-p 4567:4567 \

-p 5671:5671 \

-p 15672:15672 \

-v $PWD/check-docker.json:/etc/sensu/conf.d/check-docker.json \

hiroakis/docker-sensu-server

这样Sensu服务器就开启了,你就可以对每个运行有我们的Docker容器的主机上开启sensu客户端。你告诉容器将有一个名为load-docker-metrics.sh的脚本,所以让我们创建脚本,并将其放到我们的客户端容器内。创建该文件并添加如下所示的文本,将HOST_NAME替换为您的主机的逻辑名称。下面的脚本是为运行容器、所有容器以及镜像而使用Docker远程API来拉取元数据。然后它打印出来sensu的键值标示的值。该sensu服务器将读取标准输出并收集这些指标。这个例子只拉取这三个值,但根据需要,你可以使脚本尽可能详细。请注意,你也可以添加多个检查脚本,如thos,只要早前在服务配置文件中你引用过它们。你也可以定义你想要检查运行Docker容器数量降至三个以下的失败。你还可以使检查通过从检查脚本返回一个非零值失败。

#!/bin/bash

set -e

# Count all running containers

running_containers=$(echo -e "GET /containers/json HTTP/1.0\r\n" | nc -U /var/run/docker.sock \

| tail -n +5 \

| python -m json.tool \

| grep \"Id\" \

| wc -l)

# Count all containers

total_containers=$(echo -e "GET /containers/json?all=1 HTTP/1.0\r\n" | nc -U /var/run/docker.sock \

| tail -n +5 \

| python -m json.tool \

| grep \"Id\" \

| wc -l)

# Count all images

total_images=$(echo -e "GET /images/json HTTP/1.0\r\n" | nc -U /var/run/docker.sock \

| tail -n +5 \

| python -m json.tool \

| grep \"Id\" \

| wc -l)

echo "docker.HOST_NAME.running_containers ${running_containers}"

echo "docker.HOST_NAME.total_containers ${total_containers}"

echo "docker.HOST_NAME.total_images ${total_images}"

if [ ${running_containers} -lt 3 ]; then

exit 1;

fi

现在你已经定义了Docker载入指标检查,那就需要使用usman/sensu-client容器来启动sensu客户端。您可以使用如下所示的命令启动sensu客户端。需要注意的是,容器必须以privileged来运行以便能够访问Unix sockets,它必须有Docker socket挂载以及你上面定义的load-docker-metrics.sh脚本。确保load-docker-metrics.sh脚本在你的主机的权限标记为可执行。容器也需要将SENSU_SERVER_IP、RABIT_MQ_USER、RABIT_MQ_PASSWORD、CLIENT_NAME以及CLIENT_IP作为参数,请指定这些参数到您设置的值。其中RABIT_MQ_USER与RABIT_MQ_PASSWORD默认值是sensu和password。

docker run -d --name sensu-client --privileged \

-v $PWD/load-docker-metrics.sh:/etc/sensu/plugins/load-docker-metrics.sh \

-v /var/run/docker.sock:/var/run/docker.sock \

usman/sensu-client SENSU_SERVER_IP RABIT_MQ_USER RABIT_MQ_PASSWORD CLIENT_NAME CLIENT_IP

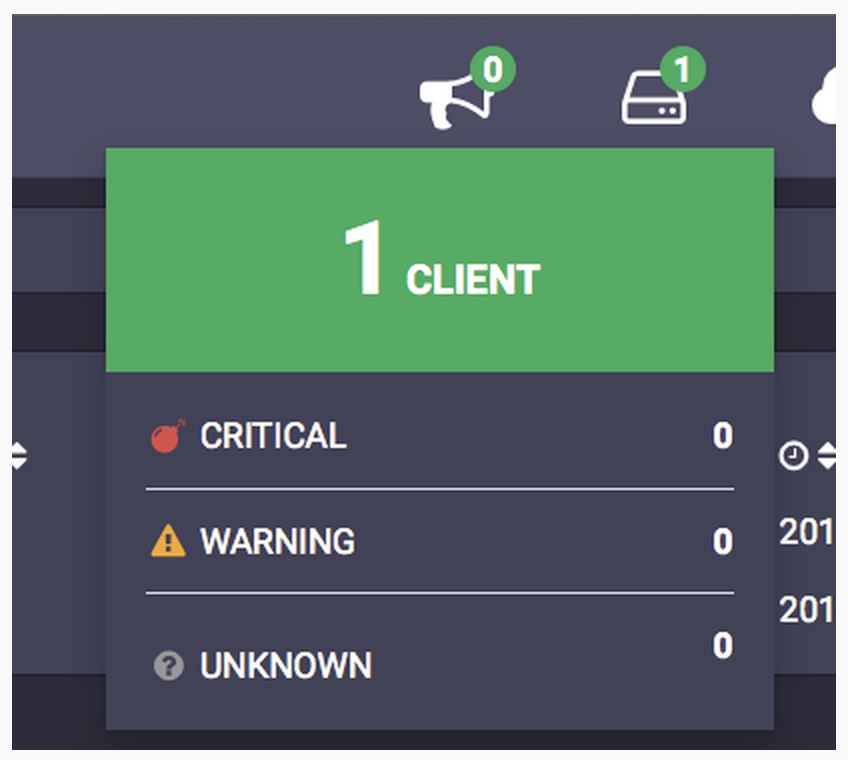

运行完此命令,一会儿你应该看到客户端计数增加1在uchiwa界面。如果您点击客户端图标,你应该看到,包括你刚才添加的客户端的客户端名单。我的客户端1是client-1以及指定的主机IP为192.168.1.1。

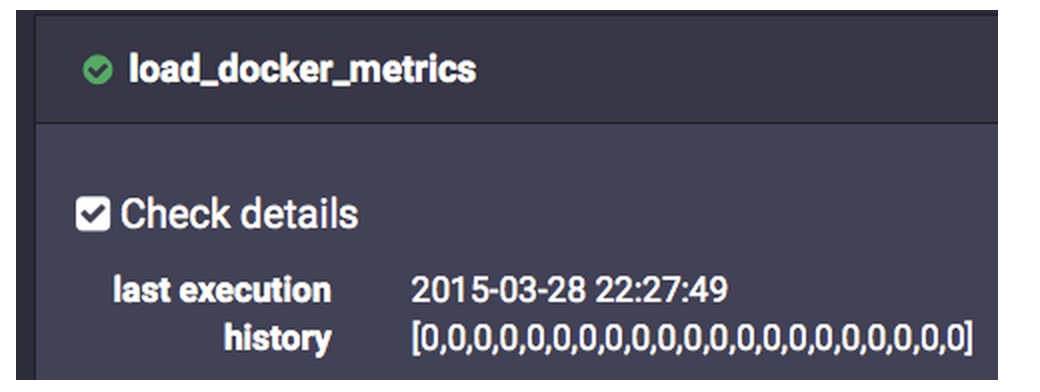

如果你点击检查名称就可以看到检查运行的进一步细节。零表明没有错误,如果脚本失败(例如,如果您的Docker守护进程死掉),你会看到一个错误代码(非零)值。虽然在目前的文章中没有涉及这个,你也还可以使用Handlers在sensu设置这些检查失败处理程序来提醒您。此外,uchiwa只显示检查的值,而不是收集的指标。需要注意的是sensu不存储所收集的指标,它们必须被转发到一个时间序列的数据库如InfluxDB或Graphite。这也是通过Handlers做到的。如何配置指标转发到graphite可以参考这里。

Sensu支持我们所有的评价标准,你可以对我们Docker容器和主机收集尽可能多的细节。此外,你能够聚合所有主机的值到一个地方,并对这些检查发出警报。这些警报并没有DataDog或Scout的先进,因为你仅能够提醒单独的主机上检查失败。然而,Sensu的大缺点是部署的难度。虽然我已经使用Docker容器自动部署许多步骤,Sensu仍然是一个需要我们安装,启动和分开维护Redis、RabitMQ、Sensu API、uchiwa与Sensu Core的复杂系统。此外,你将需要更多的工具,如Graphite来呈现指标值以及生产部署需要定制容器,今天我已经使用了一个容器为了密码的安全以及自定义的SSL证书。除了您重启容器后才能添加更多的检查,你将不得不重新启动Sensu服务,因为这是它开始收集新的标准的唯一途径。由于这些原因,我对Sensu的在易于部署的评价相当的低。

评分:

- 易于部署程度:※

- 信息详细程度:※※※※

- 集成度:※※※※

- 生成警报的能力:支持但有限

- 监测非Docker的资源的能力:※※※※※

- 成本:免费

总结今天的文章涵盖了多种选项用于监控Docker容器,从免费的选择, 如Docker stats、CAdvisor或Sensu,到有偿服务,如Scout和DataDog。我的研究到目前为止DataDog似乎是用于监控Docker部署的最好的系统。只需几秒的安装以及单行命令,所有主机都在同一个地方报告指标,在UI方面,历史趋势是显而易见的,并且Datadog支持更深层次的指标以及报警。然而,$15一个主机系统对于大型部署是昂贵的。对于较大规模,自托管部署,Sensu是能够满足大多数的要求,不过在建立和管理一个Sensu集群的复杂性可能让人望而却步。很显然,有很多其他的自托管的选项,如Nagios或Icinga,他们都类似Sensu。

原文链接:Backuping PostgreSQL with Docker https://henduan.com/hTl6m

批量删除Redis数据库中的Key

数据库 OpenSkill 发表了文章 0 个评论 3348 次浏览 2015-06-14 11:04

Redis 中有删除单个 Key 的指令 DEL,但好像没有批量删除 Key 的指令,不过我们可以借助 Linux 的 xargs 指令来完成这个动作

redis-cli keys "*" | xargs redis-cli del

//如果redis-cli没有设置成系统变量,需要指定redis-cli的完整路径

//如:/opt/redis/redis-cli keys "*" | xargs /opt/redis/redis-cli del

如果要指定 Redis 数据库访问密码,使用下面的命令

redis-cli -a password keys "*" | xargs redis-cli -a password del

删除所有Key

删除所有Key,可以使用Redis的flushdb和flushall命令

//删除当前数据库中的所有Key

flushdb

//删除所有数据库中的key

flushall

注:keys 指令可以进行模糊匹配,但如果 Key 含空格,就匹配不到了,暂时还没发现好的解决办法。

参考文档:http://stackoverflow.com/questions/5756067/how-to-empty-a-redis-database

Redis中key相关主要操作函数

数据库 OpenSkill 发表了文章 3 个评论 3230 次浏览 2015-06-13 12:31

1)keys

语法:keys pattern

解释:查找所有匹配指定模式pattern的key

[root@cjlx ~]# redis-cli2)randomkey

redis 127.0.0.1:6379> keys * #所有key

1) "score"

2) "stu"

3) "score1"

4) "dest"

5) "lst.user"

6) "lst.tect"

redis 127.0.0.1:6379> keys scor?

1) "score"

redis 127.0.0.1:6379> keys scor[ee1]

1) "score"

语法:randomkey

解释:返回一个随机key

redis 127.0.0.1:6379> randomkey3)exists

"score"

redis 127.0.0.1:6379> randomkey

"list.user"

语法:exists key

解释:判断一个key是否存在

redis 127.0.0.1:6379> exists score #key存在 返回14)type

(integer) 1

redis 127.0.0.1:6379> exists scorefda #key不存在 返回0

(integer) 0

语法:type key

解释:返回key所存储的值类型,返回值:none [key不存在],string,list ,set, zset和hash

redis 127.0.0.1:6379> type score5)expire

zset

redis 127.0.0.1:6379> type lst.user

list

语法:expire key seconds

解释:设置key的生存时间,单位是秒,当key过期时,会被自动删除

redis 127.0.0.1:6379> expire dest 306)ttl

(integer) 1

redis 127.0.0.1:6379> expire dest1 30 # key不存在

(integer) 0

语法: ttl key

解释:得到key能存活时间,如果key不存在或没有设置生存时间时,返回-1

redis 127.0.0.1:6379> expire diff 100

(integer) 1

redis 127.0.0.1:6379> ttl diff

(integer) 94

redis 127.0.0.1:6379> ttl diff

(integer) 92

7)persist

语法:persist key

解释:移除给定key的生存时间

redis 127.0.0.1:6379> ttl diff8)rename

(integer) 28

redis 127.0.0.1:6379> persist diff

(integer) 1

redis 127.0.0.1:6379> ttl diff

(integer) -1

语法:rename key newkey

解释:将key改名为newkey

redis 127.0.0.1:6379> smembers diff注意:当key和newkey相同或key不存在时,返回错误;当newkey已存在时,rename将覆盖旧值。

1) "zhangsan01"

redis 127.0.0.1:6379> rename diff diff01

OK

redis 127.0.0.1:6379> smembers diff

(empty list or set)

redis 127.0.0.1:6379> smembers diff01

1) "zhangsan01"

redis 127.0.0.1:6379> rename diff diff01

(error) ERR no such key

9)renamenx

语法:renamenx key newkey

解释:当且仅当newkey不存在时,改名key

redis 127.0.0.1:6379> renamenx diff01 stu #stu存在10)del

(integer) 0

redis 127.0.0.1:6379> renamenx diff01 diff #diff不存在

(integer) 1

语法:del key [key ...]

解释:删除一个或多个key

redis 127.0.0.1:6379> del score111)move

(integer) 1

redis 127.0.0.1:6379> del union diff aa #key aa 不存在

(integer) 2

语法:move key db

解释:将key移动到指定db

redis 127.0.0.1:6379> smembers stu #默认012)sort

1) "zhangsan01"

2) "wangwu"

redis 127.0.0.1:6379> move stu 1 #移动到 1

(integer) 1

redis 127.0.0.1:6379> smembers stu

(empty list or set)

redis 127.0.0.1:6379> select 1 #选择db 1

OK

redis 127.0.0.1:6379[1]> smembers stu

1) "zhangsan01"

2) "wangwu"

语法:sort key [BY pattern] [LIMIT offset count] [GET pattern [GET pattern ...]] [ASC|DESC] [ALPHA] [STORE destination]

解释:返回或保持给定列表,集合,有序集合key中经过排序的元素

redis 127.0.0.1:6379> sort lst.tech limit 0 2 alpha desc #按字符集排序sort虽然很“厉害”,但尽量不要让redis服务器来sort大量的数据。可以通过设定阀值减少要sort的数据,或把排序操作向前移,在web服务器或各个应用上来sort。

1) "tec06"

2) "tec05"

redis 127.0.0.1:6379> sort lst.stud

1) "1"

2) "2"

3) "3"

redis 127.0.0.1:6379> sort lst.stud desc

1) "3"

2) "2"

3) "1"

redis 127.0.0.1:6379> keys stu.*

1) "stu.name.2"

2) "stu.name.3"

3) "stu.level.1"

4) "stu.level.2"

5) "stu.level.3"

6) "stu.name.1"

redis 127.0.0.1:6379> sort lst.stud by stu.level.[i] desc get stu.level.[/i] get stu.name.*

1) "3"

2) "admin"

3) "2"

4) "joe"

5) "1"

6) "jim"

redis 127.0.0.1:6379> sort lst.stud by stu.level.[i] asc get stu.name.[/i]

1) "jim"

2) "joe"

3) "admin"